In den letzten Jahren hat die künstliche Intelligenz (KI) insbesondere im Bereich der großen Sprachmodelle (LLMs) einige bedeutende Veränderungen erfahren. Diese Modelle, wie die GPT-Serie von OpenAI (opens new window), Googles Gemini (opens new window) und Metas LLaMA (opens new window), haben erstaunliche Fähigkeiten gezeigt, wie zum Beispiel das Generieren von Texten, die menschlichem Schreiben sehr ähnlich sind. Dies macht sie unglaublich nützlich für eine Vielzahl von Aufgaben, von der Erstellung von Inhalten und der Übersetzung von Sprachen bis hin zur Lösung komplexer Probleme und der Verbesserung von Geschäftsprozessen.

LLMs können uns bei der Bewältigung von Aufgaben unterstützen, die früher manuelle Arbeit erforderten, was zu schnelleren Ergebnissen führt und neue Möglichkeiten für KI-gesteuerte Lösungen eröffnet. Mit der steigenden Nachfrage nach einzigartigen KI-Lösungen wurden bereits mehrere Tools entwickelt, um Entwicklern das einfache Erstellen von KI-Anwendungen zu ermöglichen. Zwei der beliebtesten verwendeten Technologien sind LangChain (opens new window) und AutoGen (opens new window). In diesem Blogbeitrag werfen wir einen genaueren Blick auf diese beiden Frameworks und verstehen, was sie bieten und wie sie sich unterscheiden.

# Was ist LangChain?

LangChain ist ein Framework, das die Entwicklung von Anwendungen auf Basis großer Sprachmodelle (LLMs) erleichtert, indem es die Erstellung modularer und erweiterbarer Pipelines ermöglicht. Es ermöglicht Entwicklern, verschiedene Komponenten wie Anfragen, Speicher und externe APIs in eine ausgewogene Anwendung zu integrieren. Diese Fähigkeit macht es besonders gut geeignet für den Aufbau raffinierter Konversationsagenten, Datenerfassungssysteme und anderer LLM-basierter Anwendungen.

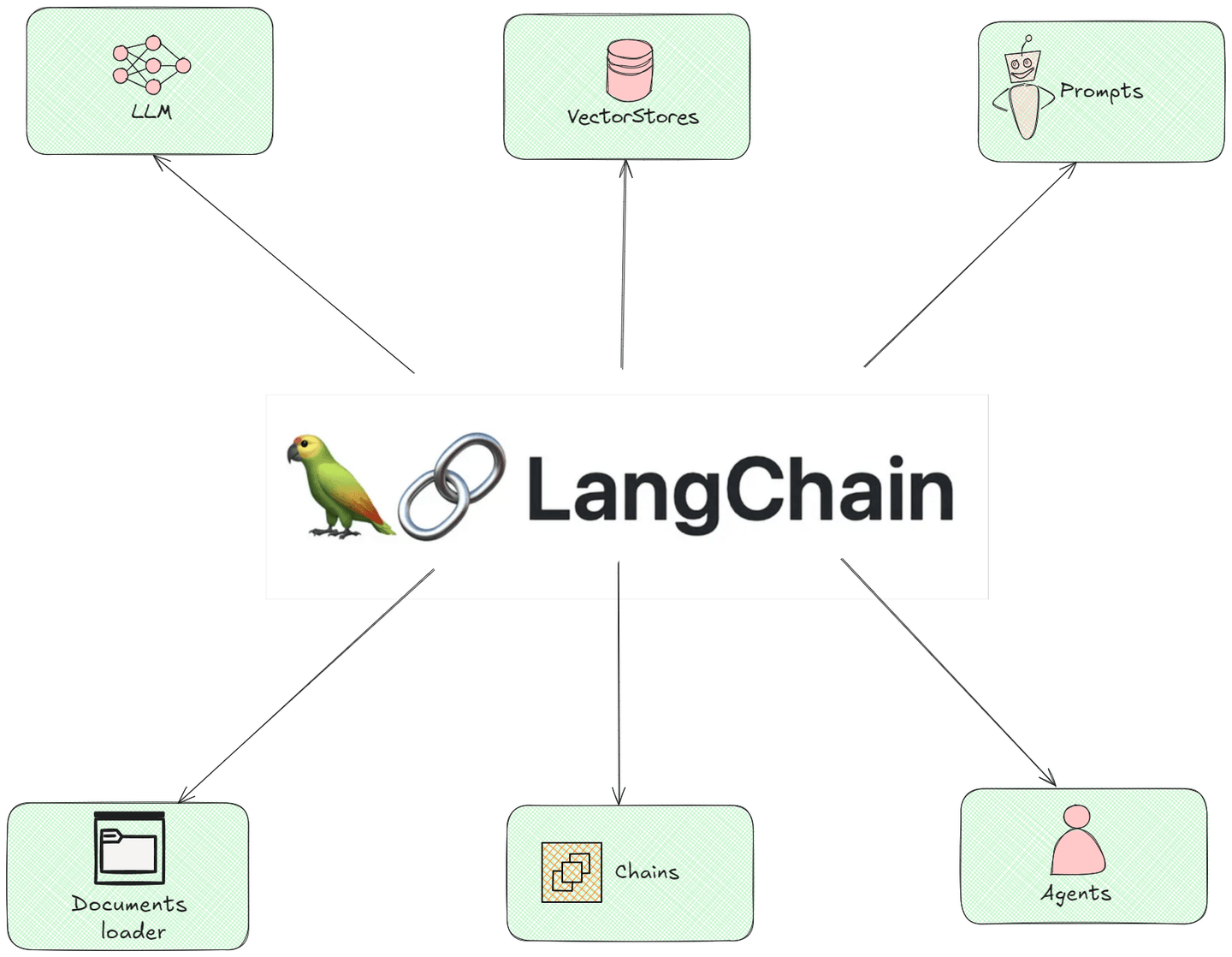

# Komponenten von LangChain

Die folgende Abbildung zeigt alle modularen Komponenten von LangChain und wie sie miteinander interagieren:

- Dokumenten-Lader: Diese Komponente funktioniert wie Helfer, die Informationen aus verschiedenen Quellen im Internet oder aus Dateien sammeln. Stellen Sie sich vor, sie sammeln alle Zutaten, die Sie zum Kochen eines Gerichts benötigen, bevor Sie mit dem Kochen beginnen.

- LLMs (Sprachmodelle): Denken Sie an diese Komponente als intelligente Roboter, die schreiben und auf Fragen antworten können. Sie haben viel gelesen, daher können sie Ihnen gute Antworten basierend auf dem, was sie gelernt haben, geben.

- Ketten: Die Kettenkomponente ist wie eine Reihe von Schritten, denen Sie folgen, um etwas zu erledigen. Wenn Sie zum Beispiel einen Kuchen backen, folgen Sie Schritten wie Zutaten mischen, Teig gießen und dann backen. Ketten führen, wie Informationen durch verschiedene Schritte fließen, um zur endgültigen Antwort zu gelangen.

- Anfragen: Dies sind die Fragen oder Anfragen, die Sie dem Sprachmodell stellen. Es ist wie die Bitte um Hilfe an einen Freund - wenn Sie die richtige Frage stellen, erhalten Sie die richtige Antwort!

- Agenten: Stellen Sie sich vor, Agenten sind wie persönliche Assistenten, die Aufgaben für Sie erledigen können. Agenten können ähnlich handeln; sie können basierend auf dem, was Sie ihnen sagen, Maßnahmen ergreifen, wie Reservierungen vornehmen oder Erinnerungen senden.

- Vektorspeicher: Die Vektorspeicher-Komponente sind spezielle Orte zur Speicherung von Informationen, damit sie bei Bedarf leicht gefunden werden können. Stellen Sie sich sie als organisierte Ordner auf Ihrem Computer vor, in denen Sie schnell nach einem Dokument suchen können, ohne durch einen unordentlichen Desktop zu wühlen.

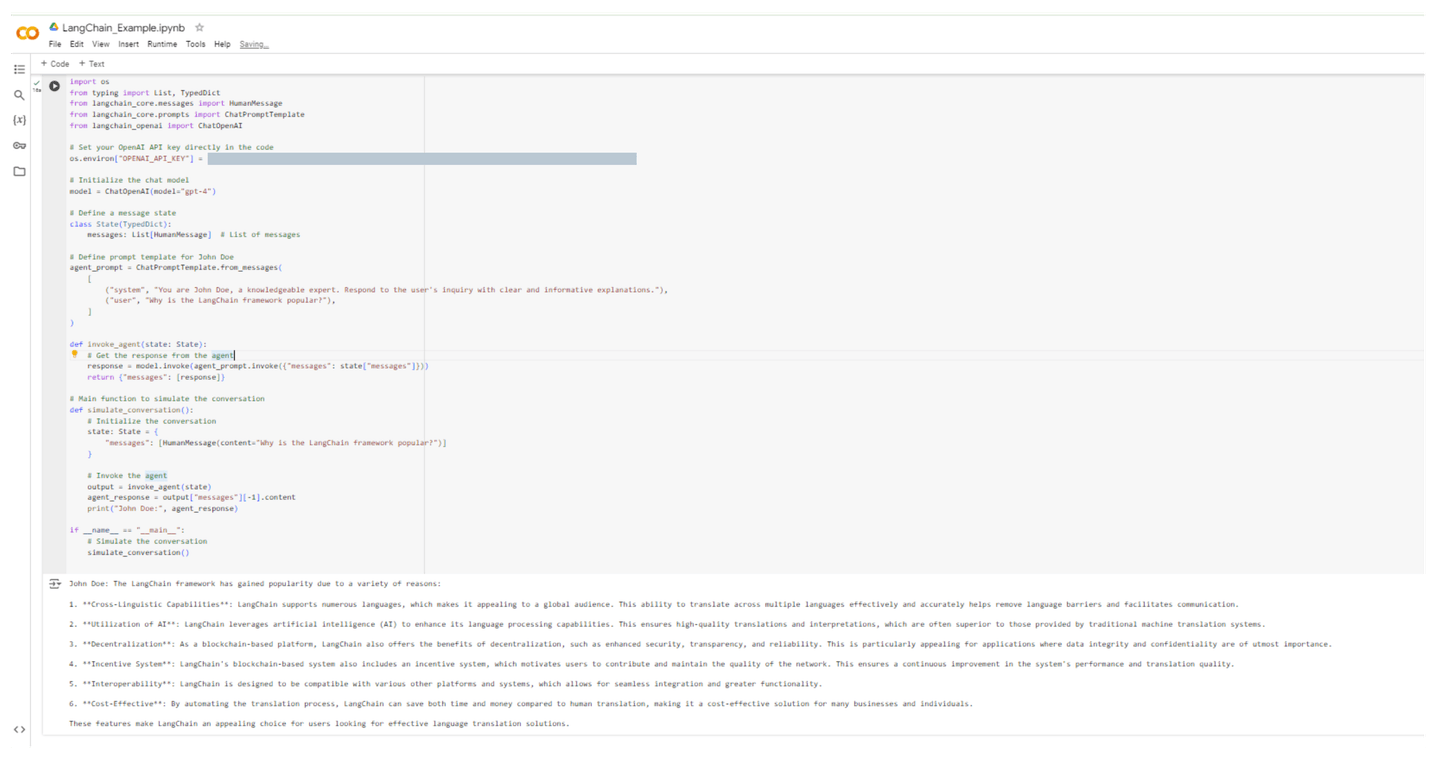

# Codebeispiel: Erstellen eines LangChain-Agenten

Im folgenden Beispiel haben wir einen LangChain-Agenten namens John Doe erstellt, der die Frage "Warum ist das LangChain-Framework beliebt?" erklären wird. Der Code sieht wie folgt aus:

import os

from typing import List, TypedDict

from langchain_core.messages import HumanMessage

from langchain_core.prompts import ChatPromptTemplate

from langchain_openai import ChatOpenAI

# Setzen Sie Ihren OpenAI API-Schlüssel direkt im Code

os.environ["OPENAI_API_KEY"] = "[OPENAI API-SCHLÜSSEL]"

# Initialisieren des Chat-Modells

model = ChatOpenAI(model="gpt-4")

# Definieren eines Nachrichtenstatus

class State(TypedDict):

messages: List[HumanMessage] # Liste von Nachrichten

# Definieren Sie eine Vorlagenanfrage für John Doe

agent_prompt = ChatPromptTemplate.from_messages(

[

("system", "Du bist John Doe, ein sachkundiger Experte. Antworte auf die Anfrage des Benutzers mit klaren und informativen Erklärungen."),

("user", "Warum ist das LangChain-Framework beliebt?"),

]

)

def invoke_agent(state: State):

# Holen Sie sich die Antwort vom Agenten

response = model.invoke(agent_prompt.invoke({"messages": state["messages"]}))

return {"messages": [response]}

# Hauptfunktion zur Simulation des Gesprächs

def simulate_conversation():

# Initialisieren des Gesprächs

state: State = {

"messages": [HumanMessage(content="Warum ist das LangChain-Framework beliebt?")]

}

# Agenten aufrufen

output = invoke_agent(state)

agent_response = output["messages"][-1].content

print("John Doe:", agent_response)

if __name__ == "__main__":

# Gespräch simulieren

simulate_conversation()

Nach Ausführung dieses Codes sehen wir uns Johns Antwort an:

John Doe: Das LangChain-Framework hat aus verschiedenen Gründen an Beliebtheit gewonnen:

1. **Sprachübergreifende Fähigkeiten**: LangChain unterstützt zahlreiche Sprachen, was es für ein globales Publikum attraktiv macht. Diese Fähigkeit zur effektiven und genauen Übersetzung über mehrere Sprachen hinweg hilft, Sprachbarrieren abzubauen und die Kommunikation zu erleichtern.

2. **Nutzung von KI**: LangChain nutzt künstliche Intelligenz (KI), um seine Sprachverarbeitungsfähigkeiten zu verbessern. Dadurch werden hochwertige Übersetzungen und Interpretationen ermöglicht, die oft besser sind als die von herkömmlichen maschinellen Übersetzungssystemen bereitgestellten.

3. **Dezentralisierung**: Als blockchain-basierte Plattform bietet LangChain auch die Vorteile der Dezentralisierung, wie erhöhte Sicherheit, Transparenz und Zuverlässigkeit. Dies ist besonders interessant für Anwendungen, bei denen Datenintegrität und Vertraulichkeit von größter Bedeutung sind.

4. **Anreizsystem**: Das blockchain-basierte System von LangChain umfasst auch ein Anreizsystem, das Benutzer dazu motiviert, zur Qualität des Netzwerks beizutragen und diese aufrechtzuerhalten. Dadurch wird eine kontinuierliche Verbesserung der Leistung und Übersetzungsqualität des Systems gewährleistet.

5. **Interoperabilität**: LangChain ist darauf ausgelegt, mit verschiedenen anderen Plattformen und Systemen kompatibel zu sein, was eine nahtlose Integration und eine größere Funktionalität ermöglicht.

6. **Kosteneffizienz**: Durch die Automatisierung des Übersetzungsprozesses kann LangChain im Vergleich zur menschlichen Übersetzung sowohl Zeit als auch Geld sparen und ist somit eine kostengünstige Lösung für viele Unternehmen und Einzelpersonen.

Diese Funktionen machen LangChain zu einer attraktiven Wahl für Benutzer, die nach effektiven Lösungen für die Sprachübersetzung suchen.

Die folgende Abbildung veranschaulicht die Ausführung dieses Codes in einer Colab-Umgebung:

Nun, da wir ein klares Verständnis von LangChain haben, gehen wir zum nächsten Framework über.

# Was ist AutoGen?

AutoGen ist ein Framework, das sich mehr auf die Automatisierung von Codegenerierungsprozessen und Workflow-Management mithilfe großer Sprachmodelle konzentriert. Sein Hauptziel besteht darin, den Entwicklungsprozess zu beschleunigen, indem es Benutzern ermöglicht, funktionalen Code zu generieren und repetitive Aufgaben durch natürliche Spracheingabe zu automatisieren. AutoGen eignet sich ideal für schnelles Prototyping und ermöglicht es Benutzern, Anwendungen und Workflows ohne umfangreiche Programmierkenntnisse zu erstellen.

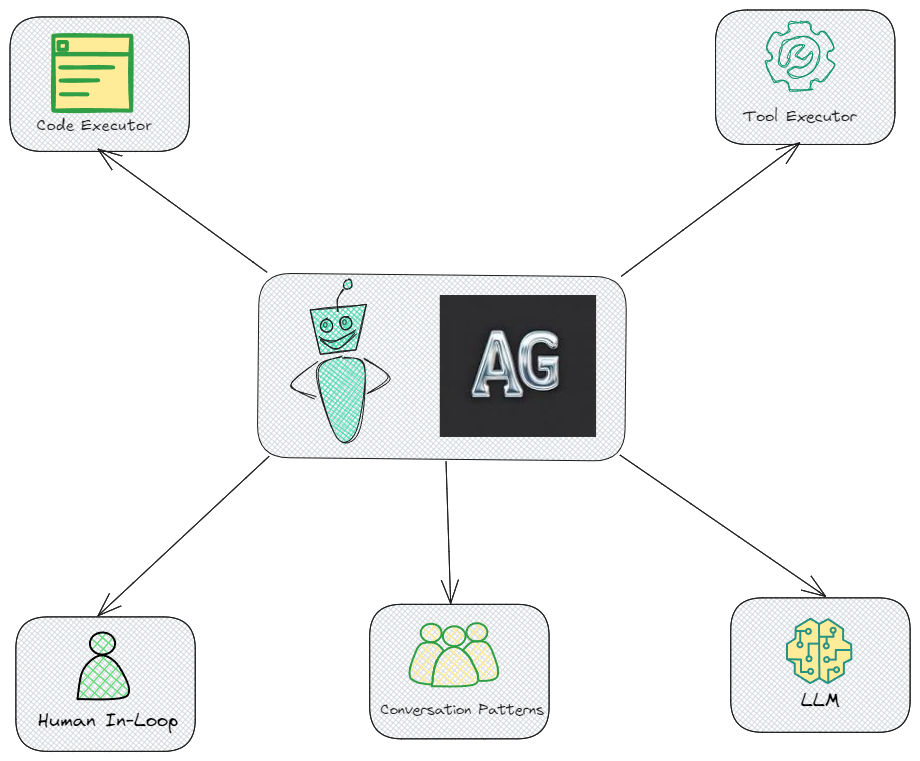

# Komponenten von AutoGen

Die folgende Abbildung zeigt alle wichtigen Komponenten von AutoGen und wie sie miteinander interagieren:

- Codeausführer: Diese Komponente ermöglicht es AutoGen, Code automatisch auszuführen. Dies ist in der Tat eine Kernfunktion, die es Agenten ermöglicht, Code basierend auf den festgelegten Zielen auszuführen.

- Toolausführer: Diese Komponente ist auch für AutoGen wesentlich und ermöglicht es dem System, mit verschiedenen externen Tools oder APIs zu interagieren.

- Menschliche Schleife: Dies ist wichtig für Fälle, in denen menschliches Eingreifen für Entscheidungsfindung oder Validierung erforderlich ist, um sicherzustellen, dass menschliche Bediener die Agenten bei Bedarf anleiten oder kontrollieren können.

- Konversationsmuster: Dies deutet darauf hin, dass AutoGen vordefinierte Konversationsstrukturen verwendet, um die Interaktion zwischen Agenten effektiv zu verwalten. Es ist ein wesentliches Element, um kohärente und zielgerichtete Dialoge zwischen Agenten zu gewährleisten.

- LLM (Large Language Model): LLMs sind in der Tat ein wesentlicher Bestandteil der Architektur von AutoGen und bieten die zugrunde liegenden Sprachfähigkeiten, die Agentenverständnis und Entscheidungsfindung antreiben.

# Codebeispiel: Erstellen eines AutoGen-Agenten

Nun erstellen wir denselben Agenten John Doe in AutoGen, der die Frage "Warum ist das AutoGen-Framework beliebt?" erklären wird. Der Code sieht wie folgt aus:

import os

from autogen import ConversableAgent

# Setzen Sie Ihren OpenAI API-Schlüssel

os.environ["OPENAI_API_KEY"] = "[OPENAI API-SCHLÜSSEL]"

# Erstellen Sie den Agenten "John Doe", der auf Anfragen antwortet

john_doe = ConversableAgent(

name="John Doe",

system_message="Du bist John Doe, ein sachkundiger Experte. Antworte auf die Anfrage des Benutzers mit klaren und informativen Erklärungen.",

llm_config={"config_list": [{"model": "gpt-4", "temperature": 0.5, "api_key": os.environ.get("OPENAI_API_KEY")}]},

human_input_mode="NEVER", # Niemals nach menschlicher Eingabe fragen.

)

# Simulieren Sie ein Gespräch

def simulate_conversation():

# Definieren Sie die Benutzerfrage

user_question = "Warum ist das AutoGen-Framework beliebt?"

# Starten Sie das Gespräch, bei dem John Doe auf die Benutzerfrage antwortet

reply = john_doe.generate_reply(messages=[{"content": user_question, "role": "user"}])

# Drucken Sie die Antwort von John Doe

print("John Doe:", reply)

if __name__ == "__main__":

# Simulieren Sie das Gespräch

simulate_conversation()

Nach Ausführung dieses Codes gibt John Doe Antworten mit folgender Erklärung:

John Doe: AutoGen ist aus verschiedenen Gründen ein beliebtes Framework:

1. Automatisierung: AutoGen ermöglicht die Automatisierung von Code- und Textgenerierung, was den Aufwand und die Zeit für die Erstellung und Wartung von Code erheblich reduzieren kann.

2. Flexibilität: AutoGen ist sehr flexibel und kann mit einer Vielzahl von Programmiersprachen und Textformaten verwendet werden. Dies macht es zu einem vielseitigen Werkzeug für Entwickler, die in verschiedenen Umgebungen arbeiten.

3. Effizienz: Durch die Automatisierung repetitiver Aufgaben kann AutoGen Fehler reduzieren und die Effizienz im Entwicklungsprozess steigern.

4. Anpassbarkeit: AutoGen unterstützt benutzerdefinierte Vorlagen, mit denen Entwickler das Tool an ihre spezifischen Anforderungen und Vorlieben anpassen können.

5. Open Source: AutoGen ist ein Open-Source-Tool, das kostenlos verwendet und modifiziert werden kann. Dadurch profitiert es auch von einer Community von Entwicklern, die zur fortlaufenden Entwicklung und Verbesserung beitragen.

6. Dokumentation: AutoGen bietet umfangreiche Dokumentation, die es neuen Benutzern erleichtert, das Tool effektiv zu erlernen.

7. Integration: Es kann problemlos mit anderen Software-Tools und Entwicklungsumgebungen integriert werden, was es zu einer praktischen Ergänzung für das Toolkit eines Entwicklers macht.

Diese Faktoren tragen zur Beliebtheit von AutoGen bei Entwicklern und Programmierern bei.

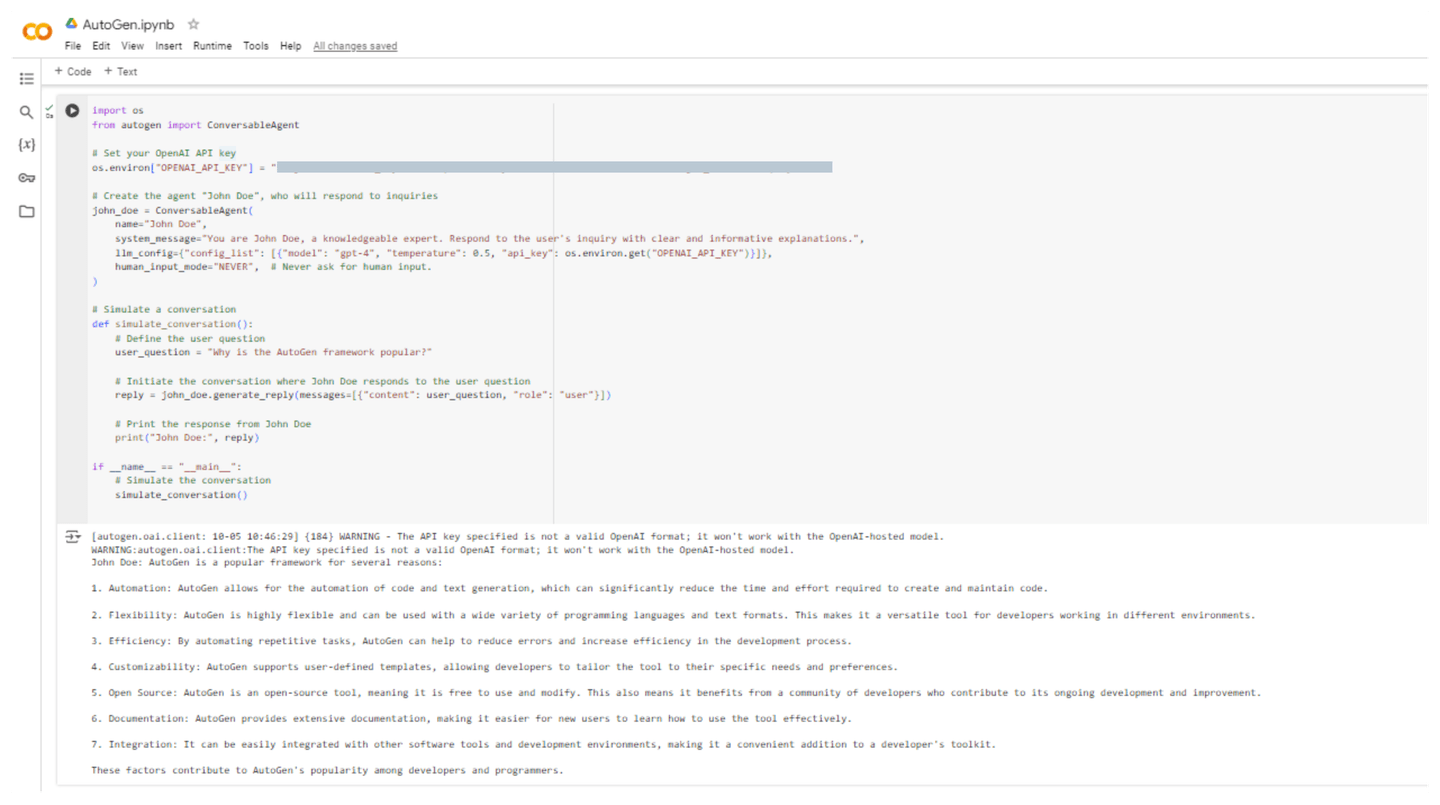

Die folgende Abbildung veranschaulicht die Ausführung dieses Codes in einer Colab-Umgebung:

# LangChain vs. AutoGen: Ein Vergleich

Hier ist eine Vergleichstabelle, die die wesentlichen Unterschiede und Gemeinsamkeiten zwischen LangChain und AutoGen darstellt. Diese Tabelle hilft Ihnen dabei, die einzigartigen Funktionen, Stärken und Anwendungsfälle jedes Frameworks zu verstehen.

| Funktion / Aspekt | LangChain | AutoGen |

|---|---|---|

| Zweck | Framework zur Entwicklung von Anwendungen unter Verwendung von Sprachmodellen, das sich auf die Verkettung von Operationen und den Datenfluss konzentriert. | Framework zur Ermöglichung komplexer Workflows mit mehreren Agenten, die kommunizieren und zusammenarbeiten können. |

| Agentenmodell | Unterstützt den Aufbau benutzerdefinierter Agenten und Workflows. | Verwendet konversationsfähige Agenten, die Nachrichten senden und empfangen können, um die Interaktion zwischen mehreren Agenten zu vereinfachen. |

| Community | Etablierte Community mit umfangreicher Dokumentation und Beispielen. +Wachsende Community mit aktiver Entwicklung und Forschungsschwerpunkt. | |

| Komplexe Workflows | Kann komplexe Workflows erstellen, aber hauptsächlich durch Verkettung von Operationen. | Entwickelt für komplexe Workflows mit mehreren Agenten, die die Interaktion zwischen ihnen erleichtern. |

| Benutzerfreundlichkeit | Einfach für diejenigen, die mit LLMs vertraut sind, aber möglicherweise eine Lernkurve für Anfänger haben. | Benutzerfreundlich für den Aufbau von Multi-Agenten-Systemen, mit Schwerpunkt auf Zusammenarbeit und Kommunikation. |

| Anwendungsfälle | Ideal für Anwendungen in der Datenverarbeitung, der Inhaltsgenerierung und bei Konversationsagenten. | Geeignet für Anwendungen, die Multi-Agenten-Systeme erfordern, wie z.B. Debatten, Kundensupport oder gemeinsame Problemlösung. |

| Integration | Integriert sich gut mit verschiedenen LLMs, Tools und externen Diensten. | Speziell für die Integration von Agenten und deren Komponenten, einschließlich menschlicher Eingabe, entwickelt. |

| Mensch-in-der-Schleife | Begrenzte Unterstützung für menschliche Beteiligung; konzentriert sich mehr auf Automatisierung. | Unterstützt Szenarien mit menschlicher Beteiligung, sodass Agenten bei Bedarf menschliche Eingabe suchen können. |

| API-Nutzung | Erfordert einen API-Schlüssel für LLMs wie OpenAI, aber weniger Fokus auf Interaktionen zwischen Agenten. | Erfordert einen API-Schlüssel für LLMs, speziell für Agenteninteraktionen und Workflows entwickelt. |

| Unterstützte Modelle | Funktioniert mit einer Vielzahl von Modellen, einschließlich GPT-3, GPT-4 und anderen. | Integriert sich hauptsächlich mit OpenAI-Modellen, kann aber auch erweitert werden, um andere Modelle zu unterstützen. |

Diese Tabelle bietet einen schnellen Überblick über die Stärken und Überlegungen sowohl von LangChain als auch von AutoGen und hilft Ihnen dabei, das Tool auszuwählen, das am besten zu den Anforderungen Ihres Projekts passt.

# Fazit

LangChain und AutoGen sind robuste Frameworks, die für verschiedene Zwecke im Bereich der künstlichen Intelligenz entwickelt wurden. LangChain spezialisiert sich auf die Erstellung organisierter Anwendungen, die Sprachmodelle mit Hilfe modularer Komponenten und Workflows nutzen. Dies macht es perfekt für Aufgaben wie die Datenverarbeitung und die Generierung von Inhalten. AutoGen hingegen zeichnet sich durch die Entwicklung interaktiver Systeme mit mehreren Agenten aus, die zusammenarbeiten und effizient kommunizieren können, um schwierige Aufgaben zu lösen und es Menschen zu erleichtern, an der Problemlösung mitzuwirken.

Durch die Kombination von MyScale (opens new window) mit beiden Frameworks wird die Funktionalität erheblich verbessert, da dies eine effektive Speicherung und Abrufung von Vektoreinbettungen ermöglicht. Diese Integration ermöglicht eine schnelle Suche nach relevanten Informationen und verbessert die Angemessenheit des Kontexts und die Genauigkeit der Antworten in Anwendungen. Darüber hinaus verbessert der MSTG-Algorithmus (opens new window) von MyScale die Such- und Abrufoperationen zur effizienten Handhabung umfangreicher Datensätze. In Kombination ermöglichen diese Tools Entwicklern den Aufbau starker und effizienter KI-basierter Plattformen.