Im Bereich der KI-Entwicklungen zeichnen sich RAG-Anwendungen als transformative Werkzeuge aus, die verschiedene Branchen umgestalten. Diese Anwendungen bieten Unternehmen einen immensen Mehrwert, indem sie die Fähigkeiten zur Datenanalyse und Vorhersage verbessern. Durch die Kombination von Abruf- und Generierungsmodellen optimieren RAG-Anwendungen den Prozess der Informationssuche (opens new window), indem sie Forschern ermöglichen, schnell auf ein umfangreiches Wissensspektrum in verschiedenen Bereichen zuzugreifen.

Unternehmen aus verschiedenen Branchen setzen zunehmend auf RAG, um ihr KI-Potenzial zu steigern. Die Fusion von Abruf- und Generierungskomponenten in RAG-Anwendungen erleichtert die Analyse umfangreicher Kundendaten und ermöglicht die Ableitung von handlungsrelevanten Erkenntnissen, die personalisierte Empfehlungen unterstützen. Diese Synergie ermöglicht es Unternehmen, das Potenzial der generativen KI (opens new window)-Technologie selbstbewusst für eine Vielzahl von Anwendungen zu nutzen. Darüber hinaus kombiniert die Architektur von RAG-Anwendungen die Informationssuche mit Modellen zur Textgenerierung (opens new window), um effektiv auf Benutzeranfragen zu reagieren.

Durch die Feinabstimmung großer Sprachmodelle mithilfe von Techniken wie der Einbettung von Quantisierung (opens new window) und Retrieval Augmented Fine Tuning (RAFT) verbessern Entwickler die Robustheit und Effizienz von RAG-Anwendungen (Quelle (opens new window)).

# Wie Claude RAG-Modelle verbessert

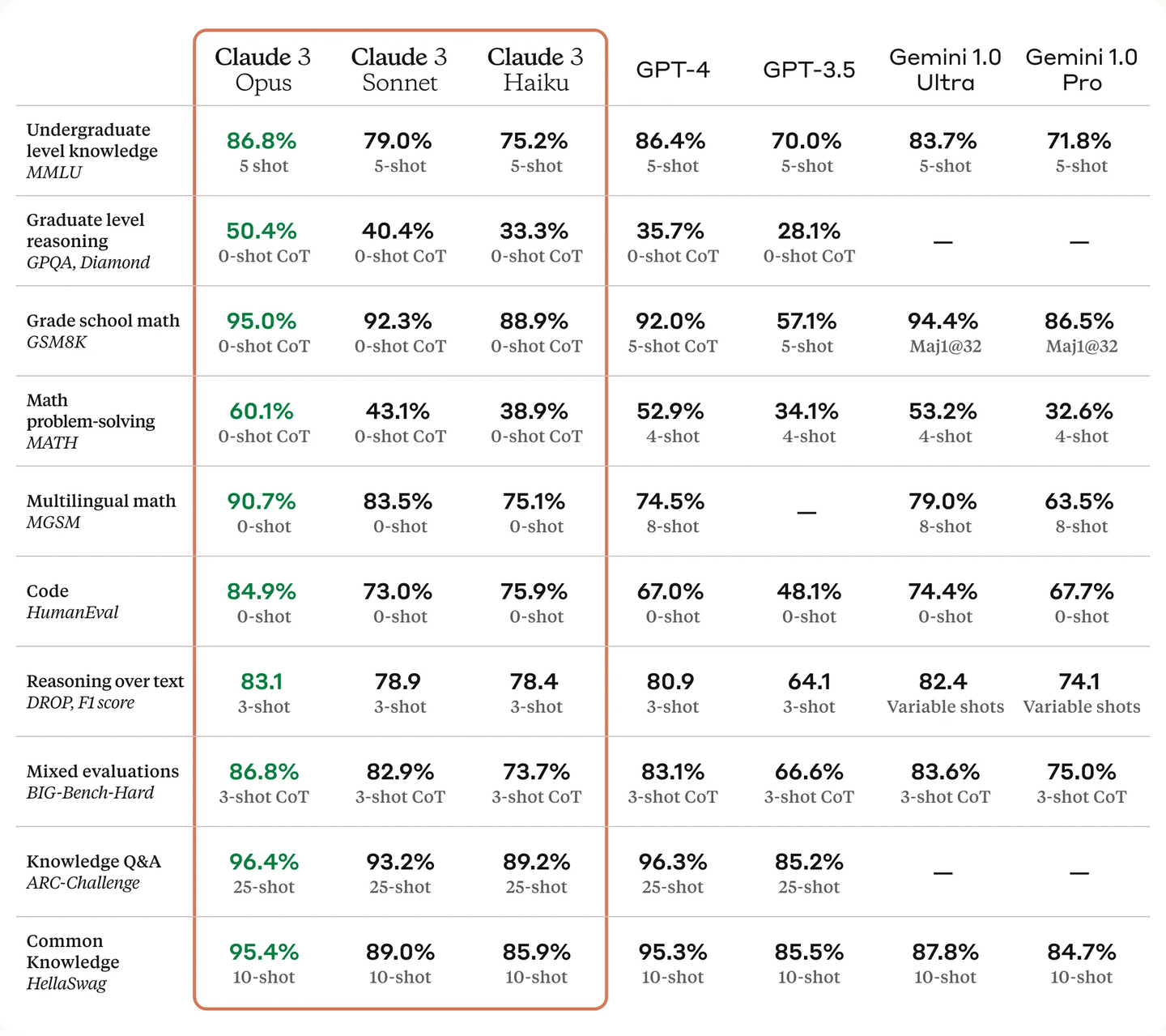

Claude 3 (opens new window), entwickelt von Anthropic, ist eine fortschrittliche KI-Modellfamilie, die neue Maßstäbe in Bezug auf Genauigkeit und Kontextverarbeitung setzt. Die Claude 3-Familie umfasst drei Modelle: Haiku, Sonnet und Opus, von denen jedes für unterschiedliche Anforderungen entwickelt wurde. Diese Modelle zeichnen sich durch hohe faktische Genauigkeit und die Fähigkeit aus, den Kontext über lange Gespräche hinweg aufrechtzuerhalten. Insbesondere das Opus-Modell übertrifft GPT-4 in mehreren Benchmarks, darunter Abschlussarbeiten auf Hochschulniveau und einfache Mathematiktests. Mit einem Kontextfenster von bis zu 200.000 Tokens (opens new window) kann Claude 3 umfangreiche Texteingaben effektiver verarbeiten als seine Konkurrenten.

Neben ihrer Leistung legen Claude 3-Modelle auch Wert auf den ethischen Einsatz von KI und Sicherheit. Sie sind darauf ausgelegt, Vorurteile zu reduzieren, die Privatsphäre der Benutzer zu schützen und auch auf komplexe Anfragen genaue Antworten zu liefern. Diese Modelle unterstützen sowohl Text- als auch visuelle Eingaben, was sie vielseitig einsetzbar macht, z. B. für die Erstellung von Inhalten und die Datenanalyse. Dank starker Partnerschaften und der Zugänglichkeit über verschiedene Plattformen sind Claude 3-Modelle gut positioniert, um Innovation und Effizienz in verschiedenen Bereichen voranzutreiben.

# Warum Hugging Face für RAG-Modelle wählen

Hugging Face (opens new window) ist eine führende Plattform, die für ihre umfangreiche Bibliothek an vorab trainierten Modellen (opens new window) bekannt ist, die für verschiedene Aufgaben im Bereich der natürlichen Sprachverarbeitung optimiert sind, einschließlich der Retrieval-Augmented Generation (RAG) (opens new window). Diese Modelle umfassen dichte Abrufmodelle, Sequenz-zu-Sequenz-Generierung und andere fortgeschrittene Aufgaben, was es Entwicklern erleichtert, verschiedene RAG-Konfigurationen einzurichten und zu experimentieren. Die benutzerfreundlichen APIs und die umfassende Dokumentation der Plattform vereinfachen zusätzlich den Integrations- und Feinabstimmungsprozess, sodass auch Neueinsteiger in RAG-Modelle schnell effektive Systeme implementieren können. Durch die Nutzung von Hugging Face-Tools wie LangChain und Ray können Entwickler skalierbare und leistungsstarke RAG-Systeme erstellen, die große Datenmengen und komplexe Anfragen effizient verarbeiten.

In diesem Blog werden wir uns speziell auf die Verwendung von Hugging Face-Einbettungsmodellen konzentrieren. Hugging Face bietet eine Vielzahl von Einbettungsmodellen an, die für den ersten Schritt von RAG-Systemen entscheidend sind: die Abruf relevanter Dokumente. Diese Modelle sind darauf ausgelegt, hochwertige Einbettungen zu erzeugen, die für eine genaue und effiziente Informationssuche unerlässlich sind. Durch die Verwendung von Hugging Face-Einbettungsmodellen können wir sicherstellen, dass unser RAG-System den relevantesten Kontext für eine bestimmte Anfrage abruft und so die Gesamtgenauigkeit und Leistung der generierten Antworten verbessert. Diese Wahl ermöglicht es uns, die Robustheit und Vielseitigkeit der Angebote von Hugging Face zu nutzen und gleichzeitig unsere Implementierung an die spezifischen Anforderungen der Einbettungsgenerierung anzupassen.

# Erstellen einer RAG-Anwendung mit Claude 3 und Hugging Face-Einbettungen

Nun wollen wir eine RAG-Anwendung mit Claude 3 und Hugging Face-Einbettungsmodellen erstellen. Wir werden die Schritte zum Einrichten der Umgebung, zum Laden von Dokumenten, zum Erstellen von Einbettungen und zur Verwendung des Claude 3-Modells zum Generieren von Antworten aus den abgerufenen Dokumenten durchgehen.

# Einrichten der Umgebung

Zunächst müssen wir die erforderlichen Bibliotheken installieren. Entkommentieren Sie die folgende Zeile und führen Sie sie aus, um die erforderlichen Pakete zu installieren. Wenn die Bibliotheken bereits auf Ihrem System installiert sind, können Sie diesen Schritt überspringen.

pip install langchain sentence-transformers anthropic

Damit werden die für unser RAG-System benötigten Bibliotheken langchain, sentence-transformers und anthropic installiert.

# Einrichten von Umgebungsvariablen

Als nächstes müssen wir die Umgebungsvariablen für die Verbindungen zu MyScale und der Claude 3-API einrichten. Wir werden MyScaleDB (opens new window) als Vektordatenbank für diese RAG-Anwendung verwenden, da sie eine hohe Leistung, Skalierbarkeit und effiziente Datenabrufmöglichkeiten bietet.

import os

# Einrichten der Verbindungen zur Vektordatenbank

os.environ["MYSCALE_HOST"] = "Ihr-Host-Name"

os.environ["MYSCALE_PORT"] = "443"

os.environ["MYSCALE_USERNAME"] = "Ihr-Benutzername"

os.environ["MYSCALE_PASSWORD"] = "Ihr-Passwort"

# Einrichten des API-Schlüssels für Claude 3

os.environ["ANTHROPIC_API_KEY"] = "Ihr-Claude-API-Schlüssel"

Dieses Skript richtet die erforderlichen Umgebungsvariablen für die Verbindung zur MyScale-Vektordatenbank und zur Claude 3-API ein.

Hinweis:

Wenn Sie noch kein MyScaleDB-Konto haben, können Sie die MyScale-Website (opens new window) besuchen, um sich für ein kostenloses Konto anzumelden, und der Schnellstartanleitung (opens new window) folgen. Um die Claude 3-API zu verwenden, müssen Sie ein Konto in der Claude-Konsole (opens new window) erstellen.

# Erforderliche Bibliotheken importieren

Dann importieren wir die erforderlichen Bibliotheken zum Laden, Aufteilen, Einbetten und Interagieren mit dem Claude 3-Modell.

# Zum Aufteilen der Dokumente in Abschnitte

from langchain.text_splitter import RecursiveCharacterTextSplitter

# Zur Verwendung von MyScale als Vektordatenbank

from langchain_community.vectorstores import MyScale

# Zur Verwendung von Hugging Face für Einbettungen

from langchain_huggingface import HuggingFaceEmbeddings

# Zum Laden einer Wikipedia-Seite

from langchain_community.document_loaders.wikipedia import WikipediaLoader

import anthropic

Diese Bibliotheken helfen uns dabei, Dokumente zu verwalten, Einbettungen zu erstellen und mit dem Claude 3-Modell zu interagieren.

# Initialisieren des Claude 3-Clients

Initialisieren Sie den Client für die Claude 3-API, um mit dem Modell zu kommunizieren.

client = anthropic.Anthropic()

# Laden von Dokumenten

Für dieses Beispiel laden wir Dokumente von Wikipedia mithilfe des WikipediaLoader.

loader = WikipediaLoader(query="Fifa")

# Dokumente laden

docs = loader.load()

Dies lädt Dokumente zum Thema "Fifa" von Wikipedia.

# Aufteilen der Dokumente

Wir teilen die geladenen Dokumente mithilfe von RecursiveCharacterTextSplitter in handhabbare Abschnitte auf.

character_splitter = RecursiveCharacterTextSplitter(

chunk_size=1000,

chunk_overlap=200

)

docs = character_splitter.split_documents(docs)

Dadurch werden die Dokumente in Abschnitte von 1000 Zeichen mit einer Überlappung von 200 Zeichen aufgeteilt.

# Erstellen von Einbettungen

Als nächstes verwenden wir ein Hugging Face-Einbettungsmodell, um Einbettungen für unsere Dokumentenabschnitte zu erstellen.

embeddings = HuggingFaceEmbeddings(model_name="BAAI/bge-base-en-v1.5")

docsearch = MyScale(embedding_function=embeddings.embed_documents)

docsearch.add_documents(docs)

Dieser Schritt generiert Einbettungen für die Dokumentenabschnitte und fügt sie unserer MyScale-Vektordatenbank hinzu.

# Testen der Dokumentsuche

Wir testen die Funktionalität der Dokumentsuche, um sicherzustellen, dass unsere Einbettungen und Vektordatenbank korrekt funktionieren.

query = "Wer hat die Fifa Fifa 2022 gewonnen?"

docs = docsearch.similarity_search(query, 3)

docs

Dies führt eine Ähnlichkeitssuche mit der Anfrage "Wer hat die Fifa Fifa 2022 gewonnen?" durch und ruft die drei relevantesten Dokumente ab. Es werden Dokumente wie folgt zurückgegeben:

[Dokument(seiteninhalt="Die FIFA-Weltmeisterschaft, oft als Weltmeisterschaft bezeichnet, ist ein internationaler Fußballwettbewerb zwischen den Nationalmannschaften der Männer, die Mitglieder der Fédération Internationale de Football Association (FIFA), dem globalen Dachverband des Sports, sind. Das Turnier findet alle vier Jahre statt, seit dem Eröffnungsturnier 1930, mit Ausnahme von 1942 und 1946 aufgrund des Zweiten Weltkriegs. Die amtierenden Meister sind Argentinien, die bei der Weltmeisterschaft 2022 ihren dritten Titel gewonnen haben.\\nDer Wettbewerb beginnt mit der Qualifikationsphase, die in den drei Jahren vor dem Turnier stattfindet, um zu bestimmen, welche Mannschaften sich für die Turnierphase qualifizieren. In der Turnierphase konkurrieren 32 Mannschaften etwa einen Monat lang an Spielstätten im Gastgeberland. Das Gastgeberland qualifiziert sich automatisch für die Gruppenphase des Turniers. Der Wettbewerb soll ab dem Jahr 2026 auf 48 Mannschaften erweitert werden.", metadaten={'quelle': '<https://de.wikipedia.org/wiki/FIFA-Weltmeisterschaft>', 'zusammenfassung': "Die FIFA-Weltmeisterschaft, oft als Weltmeisterschaft bezeichnet, ist ein internationaler Fußballwettbewerb zwischen den Nationalmannschaften der Männer, die Mitglieder der Fédération Internationale de Football Association (FIFA), dem globalen Dachverband des Sports, sind. Das Turnier findet alle vier Jahre statt, seit dem Eröffnungsturnier 1930, mit Ausnahme von 1942 und 1946 aufgrund des Zweiten Weltkriegs. Die amtierenden Meister sind Argentinien, die bei der Weltmeisterschaft 2022 ihren dritten Titel gewonnen haben.\\nDer Wettbewerb beginnt mit der Qualifikationsphase, die in den drei Jahren vor dem Turnier stattfindet, um zu bestimmen, welche Mannschaften sich für die Turnierphase qualifizieren. In der Turnierphase konkurrieren 32 Mannschaften etwa einen Monat lang an Spielstätten im Gastgeberland. Das Gastgeberland qualifiziert sich automatisch für die Gruppenphase des Turniers. Der Wettbewerb soll ab dem Jahr 2026 auf 48 Mannschaften erweitert werden.\\nBis zur FIFA-Weltmeisterschaft 2022 wurden 22 Endrunden seit der Einführung der Veranstaltung im Jahr 1930 ausgetragen, und insgesamt haben 80 Nationalmannschaften teilgenommen. Der Pokal wurde von acht Nationalmannschaften gewonnen. Mit fünf Siegen ist Brasilien das einzige Team, das in jedem Turnier gespielt hat. Die anderen Weltmeister sind Deutschland und Italien mit jeweils vier Titeln; Argentinien mit drei Titeln; Frankreich und der Erstgewinner Uruguay mit jeweils zwei Titeln; und England und Spanien mit jeweils einem Titel.\\nDie Weltmeisterschaft ist das prestigeträchtigste Fußballturnier der Welt und gleichzeitig das meistgesehene und verfolgte Einzelsportereignis der Welt. Die Zuschauerzahl der Weltmeisterschaft 2018 wurde auf 3,57 Milliarden geschätzt, was etwa der Hälfte der Weltbevölkerung entspricht, während das Engagement für die Weltmeisterschaft 2022 auf 5 Milliarden geschätzt wurde, wobei etwa 1,5 Milliarden Menschen das Finale gesehen haben.\\nSiebzehn Länder haben die Weltmeisterschaft ausgerichtet, zuletzt Katar, das die Veranstaltung 2022 ausrichtete. Die Veranstaltung 2026 wird gemeinsam von Kanada, den Vereinigten Staaten und Mexiko ausgerichtet, wodurch Mexiko die Auszeichnung erhält, das erste Land zu sein, das Spiele in drei Weltmeisterschaften ausrichtet.\\n\\n", 'titel': 'FIFA-Weltmeisterschaft'}),

Dokument(seiteninhalt="Die FIFA-Weltmeisterschaft 2026, vermarktet als FIFA World Cup 26, wird die 23. FIFA-Weltmeisterschaft sein, die alle vier Jahre stattfindende internationale Fußballmeisterschaft der Männer, die von den Nationalmannschaften der Mitgliedsverbände der FIFA ausgetragen wird. Das Turnier findet vom 11. Juni bis 19. Juli 2026 statt. Es wird gemeinsam von 16 Städten in drei nordamerikanischen Ländern ausgerichtet: Kanada, Mexiko und den Vereinigten Staaten. Das Turnier wird das erste sein, das von drei Nationen ausgerichtet wird, und die erste nordamerikanische Weltmeisterschaft seit 1994. Argentinien ist der Titelverteidiger.", metadaten={'quelle': '<https://de.wikipedia.org/wiki/Fu%C3%9Fball-Weltmeisterschaft_2026>', 'zusammenfassung': "Die FIFA-Weltmeisterschaft 2026, vermarktet als FIFA World Cup 26, wird die 23. FIFA-Weltmeisterschaft sein, die alle vier Jahre stattfindende internationale Fußballmeisterschaft der Männer, die von den Nationalmannschaften der Mitgliedsverbände der FIFA ausgetragen wird. Das Turnier findet vom 11. Juni bis 19. Juli 2026 statt. Es wird gemeinsam von 16 Städten in drei nordamerikanischen Ländern ausgerichtet: Kanada, Mexiko und den Vereinigten Staaten. Das Turnier wird das erste sein, das von drei Nationen ausgerichtet wird, und die erste nordamerikanische Weltmeisterschaft seit 1994. Argentinien ist der Titelverteidiger.\\nDieses Turnier wird das erste sein, an dem 48 Mannschaften teilnehmen, erweitert von 32. Das United 2026-Gebot setzte sich bei einer finalen Abstimmung auf dem 68. FIFA-Kongress in Moskau gegen ein konkurrierendes Gebot von Marokko durch. Es wird die erste Weltmeisterschaft seit 2002 sein, die von mehr als einem Land ausgerichtet wird. Mit den bisherigen Ausrichtungen der Turniere 1970 und 1986 wird Mexiko das erste Land, das die Männer-Weltmeisterschaft dreimal ausrichtet oder mitausrichtet. Die Vereinigten Staaten haben zuletzt die Männer-Weltmeisterschaft 1994 ausgerichtet, während es für Kanada das erste Mal ist, dass es die Männer-Weltmeisterschaft ausrichtet oder mitausrichtet. Die Veranstaltung kehrt auch zu ihrem traditionellen Termin im nördlichen Sommer zurück, nachdem die Ausgabe 2022 in Katar im November und Dezember stattgefunden hat.", 'titel': 'Fußball-Weltmeisterschaft 2026'}),

Dokument(seiteninhalt="Die FIFA-Weltmeisterschaft 2022 war die 22. FIFA-Weltmeisterschaft, die Weltmeisterschaft für Fußballnationalmannschaften, die von der FIFA organisiert wird. Sie fand vom 20. November bis 18. Dezember 2022 in Katar statt, nachdem dem Land 2010 die Ausrichtungsrechte zugesprochen wurden. Es war die erste Weltmeisterschaft, die in der arabischen Welt und der muslimischen Welt stattfand, und die zweite, die vollständig in Asien stattfand, nach dem Turnier 2002 in Südkorea und Japan.\\nDieses Turnier war das letzte mit 32 teilnehmenden Mannschaften, da die Anzahl der Mannschaften für die Ausgabe 2026 auf 48 erhöht wurde. Um den Extremen des heißen Klimas in Katar zu entgehen, fand die Veranstaltung im November und Dezember statt, anstelle der traditionellen Monate Mai, Juni oder Juli. Sie wurde über einen verkürzten Zeitraum von 29 Tagen mit 64 Spielen in acht Spielstätten in fünf Städten ausgetragen. Katar trat als Gastgeberland automatisch mit seiner Nationalmannschaft an der Veranstaltung teil, zusammen mit 31 Mannschaften, die durch den Qualifikationsprozess ermittelt wurden.", metadaten={'quelle': '<https://de.wikipedia.org/wiki/Fu%C3%9Fball-Weltmeisterschaft_2022>', 'zusammenfassung': "Die FIFA-Weltmeisterschaft 2022 war die 22. FIFA-Weltmeisterschaft, die Weltmeisterschaft für Fußballnationalmannschaften, die von der FIFA organisiert wird. Sie fand vom 20. November bis 18. Dezember 2022 in Katar statt, nachdem dem Land 2010 die Ausrichtungsrechte zugesprochen wurden. Es war die erste Weltmeisterschaft, die in der arabischen Welt und der muslimischen Welt stattfand, und die zweite, die vollständig in Asien stattfand, nach dem Turnier 2002 in Südkorea und Japan.\\nDieses Turnier war das letzte mit 32 teilnehmenden Mannschaften, da die Anzahl der Mannschaften für die Ausgabe 2026 auf 48 erhöht wurde. Um den Extremen des heißen Klimas in Katar zu entgehen, fand die Veranstaltung im November und Dezember statt, anstelle der traditionellen Monate Mai, Juni oder Juli. Sie wurde über einen verkürzten Zeitraum von 29 Tagen mit 64 Spielen in acht Spielstätten in fünf Städten ausgetragen. Katar trat als Gastgeberland automatisch mit seiner Nationalmannschaft an der Veranstaltung teil, zusammen mit 31 Mannschaften, die durch den Qualifikationsprozess ermittelt wurden.\\nArgentinien wurde nach einem 3:3-Unentschieden nach Verlängerung im Elfmeterschießen gegen den Titelverteidiger Frankreich mit 4:2 zum Champion gekrönt. Es war Argentiniens dritter Titel und der erste seit 1986, und es war auch die erste Nation außerhalb Europas, die das Turnier seit 2002 gewonnen hat. Der französische Spieler Kylian Mbappé wurde der erste Spieler, der seit Geoff Hurst im Finale von 1966 einen Hattrick in einem WM-Finale erzielte, und gewann den Goldenen Schuh, da er die meisten Tore (acht) während des Turniers erzielte. Mbappé wurde auch der erste Spieler, der in zwei aufeinanderfolgenden Endspielen traf, seit Vavá aus Brasilien dies 1958 und 1962 tat. Der argentinische Kapitän Lionel Messi wurde zum besten Spieler des Turniers gewählt und gewann den Goldenen Ball. Das Turnier wurde als außergewöhnlich poetisch angesehen und markierte den Höhepunkt seiner Karriere, erfüllte für einige Kommentatoren ein zuvor unerfülltes Kriterium, um als einer der größten Spieler aller Zeiten angesehen zu werden. Die Teamkollegen Emiliano Martínez und Enzo Fernández gewannen den Goldenen Handschuh, der dem besten Torhüter des Turniers verliehen wird, und den Preis für den besten jungen Spieler des Turniers, respectively. Mit 172 Toren stellte das Turnier einen Rekord für die höchste Anzahl von Toren im 32-Team-Format auf, wobei jede teilnehmende Mannschaft mindestens ein Tor erzielte. Marokko wurde die erste afrikanische Nation, die die Gruppenphase mit 7 Punkten anführte.\\nDie Entscheidung, die Weltmeisterschaft in Katar auszurichten, stieß auf erhebliche Kritik, wobei Bedenken hinsichtlich des Umgangs des Landes mit Wanderarbeitern, Frauen und Mitgliedern der LGBT-Gemeinschaft sowie des Klimas in Katar, des Fehlens einer starken Fußballkultur, von Terminänderungen und Vorwürfen der Bestechung bei der Vergabe von Austragungsrechten und der weiteren FIFA-Korruption geäußert wurden.", 'titel': 'Fußball-Weltmeisterschaft 2022'})]

Als nächstes verwenden wir das Claude 3-Modell, um das gewünschte Ergebnis aus dem abgerufenen Kontext zu erhalten.

# Vorbereiten des Anfragekontexts

Wir bereiten den Kontext aus den abgerufenen Dokumenten für das Claude 3-Modell vor.

stre = "".join(doc.page_content for doc in docs)

Dies verbindet den Inhalt der abgerufenen Dokumente zu einem einzigen String.

# Festlegen des Modells

Geben Sie das Modell an, das wir für die Generierung von Antworten verwenden möchten.

model = 'claude-3-opus-20240229'

# Generieren der Antwort

Schließlich verwenden wir das Claude 3-Modell, um basierend auf dem bereitgestellten Kontext eine Antwort zu generieren.

response = client.messages.create(

system = "Du bist ein hilfreicher Forschungsassistent. Dir werden Daten aus einer umfangreichen Wissensbasis gezeigt. Du musst die Anfrage aus dem bereitgestellten Kontext beantworten.",

messages=[

{"role": "user", "content": "Kontext: " + stre + "\\\\n\\\\n Anfrage: " + query},

],

model= model,

temperature=0,

max_tokens=160

)

response.content[0].text

Dieses Skript sendet den Kontext und die Anfrage an das Claude 3-Modell und ruft die generierte Antwort ab. Sie erhalten eine Ausgabe wie diese:

"Gemäß dem bereitgestellten Kontext hat Argentinien die FIFA-Weltmeisterschaft 2022 gewonnen und ist damit der amtierende Champion. Der Abschnitt besagt:\\n\\n'Die amtierenden Meister sind Argentinien, die bei der Weltmeisterschaft 2022 ihren dritten Titel gewonnen haben.'"

Indem wir diesen Schritten folgen, haben wir eine RAG-Anwendung erstellt, die Hugging Face-Einbettungen und das Claude 3-Modell verwendet, um Antworten aus einer Wissensbasis abzurufen und zu generieren.

# Warum MyScaleDB für RAG-Modelle wählen?

MyScaleDB zeichnet sich als optimale Wahl für RAG-Anwendungen aus, da es eine Kombination aus fortschrittlichen Vektorsuchfunktionen und SQL-Unterstützung bietet. Auf Basis von ClickHouse ermöglicht es eine nahtlose Integration von Vektor- und strukturierten Daten, was komplexe und effiziente Abfragen ermöglicht. Diese Integration vereinfacht das Datenmanagement und verbessert die Leistung und Genauigkeit des RAG-Systems, wodurch große Datenmengen effizient verarbeitet werden können.

Ein weiterer bedeutender Vorteil von MyScaleDB ist seine Kosteneffizienz und Skalierbarkeit. Es wurde entwickelt, um eine der kostengünstigsten Vektordatenbanken auf dem Markt zu sein und gleichzeitig eine überlegene Leistung im Vergleich zu seinen Konkurrenten zu bieten. Es bietet fortschrittliche Vektorindexierungstechniken wie Multi-Scale Tree Graph (MSTG), die den Ressourcenverbrauch reduzieren und die Präzision verbessern. Funktionen wie dynamisches Batching und Multithreading unterstützen hohe Volumina von gleichzeitigen Anfragen und gewährleisten eine geringe Latenz und hohe Durchsatzraten. Diese Fähigkeiten machen MyScaleDB zu einer zuverlässigen und effizienten Datenbanklösung für skalierbare RAG-Anwendungen.

# Fazit

Die Entwicklung einfacher RAG-Anwendungen ist relativ unkompliziert, aber deren Optimierung und die Aufrechterhaltung der Genauigkeit der Antworten ist eine Herausforderung. Daher ist die richtige Wahl der Werkzeuge wie LLMs, Vektordatenbanken und Einbettungsmodellen entscheidend. Jede Komponente spielt eine wichtige Rolle, um sicherzustellen, dass die Anwendung effizient läuft und genaue und relevante Antworten liefert.

Die Wahl der Vektordatenbank ist besonders wichtig, da sie den notwendigen Kontext für das LLM bereitstellt. MyScaleDB (opens new window) hat sich als leistungsfähiger als führende Vektordatenbanken (opens new window) in Bezug auf Leistung und Genauigkeit erwiesen. Darüber hinaus bietet MyScaleDB neuen Benutzern 5 Millionen kostenlose Vektorspeicher, damit sie die Funktionalitäten testen und die Vorteile selbst erleben können. Dies macht es zu einer ausgezeichneten Wahl für diejenigen, die leistungsstarke RAG-Systeme aufbauen möchten.