En los últimos años, la inteligencia artificial (IA) ha experimentado algunas transformaciones importantes, especialmente en el ámbito de los modelos de lenguaje grandes (LLM, por sus siglas en inglés). Estos modelos, como la serie GPT de OpenAI (opens new window), Gemini de Google y Metas LLaMA (opens new window), han demostrado capacidades sorprendentes como generar texto casi similar a la escritura humana. Esto los hace increíblemente útiles en una amplia gama de tareas, desde escribir contenido y traducir idiomas hasta resolver problemas complejos y mejorar los procesos empresariales.

Los LLM pueden ayudarnos a manejar tareas que solían requerir trabajo manual en el pasado, lo que permite obtener resultados más rápidos y abre nuevas oportunidades para soluciones impulsadas por IA. Con la creciente demanda de soluciones de IA únicas, ya se han desarrollado varias herramientas para ayudar a los desarrolladores a construir aplicaciones de IA de manera más fácil. Dos de las tecnologías más populares utilizadas son LangChain (opens new window) y AutoGen (opens new window). En esta publicación de blog, analizaremos más de cerca estos dos marcos y entenderemos qué ofrecen y cómo son diferentes.

# ¿Qué es LangChain?

LangChain es un marco diseñado para facilitar el desarrollo de aplicaciones basadas en modelos de lenguaje grandes (LLM) al permitir la creación de tuberías modulares y extensibles. Permite a los desarrolladores integrar diferentes componentes, como indicaciones, memoria y API externas, en una aplicación bien equilibrada. Esta capacidad lo hace especialmente adecuado para construir agentes conversacionales refinados, sistemas de recuperación de datos y otras aplicaciones basadas en LLM.

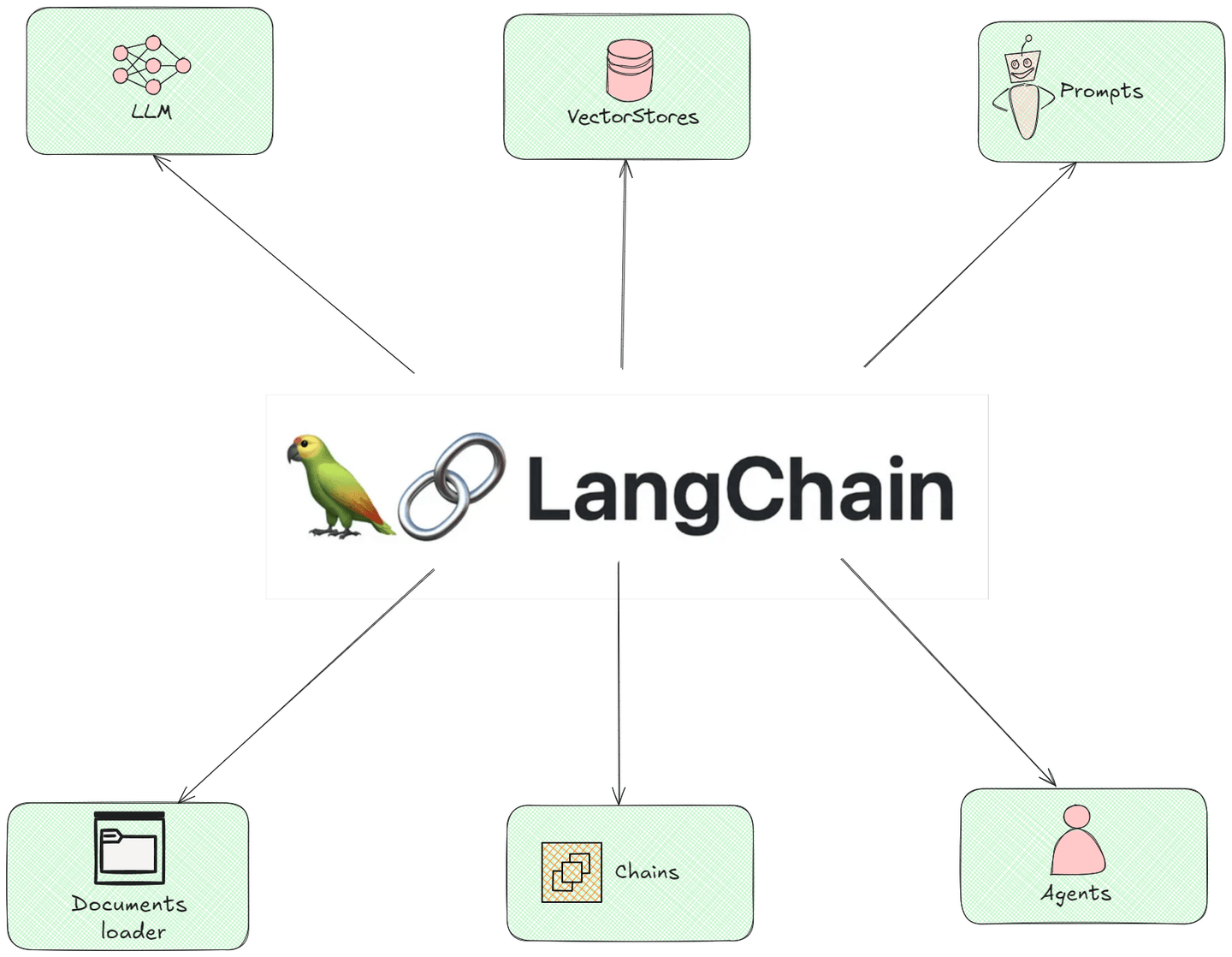

# Componentes de LangChain

La siguiente ilustración muestra todos los componentes modulares de LangChain, mostrando cómo interactúan entre sí:

- Cargadores de documentos: Este componente funciona como ayudantes que recopilan información de diferentes lugares en Internet o de archivos que tienes. Imagina que están recolectando todos los ingredientes que necesitas para hacer un plato antes de comenzar a cocinar.

- LLMs (Modelos de Lenguaje): Piensa en este componente como robots inteligentes que pueden escribir y responder preguntas. Han leído muchas cosas, por lo que pueden darte buenas respuestas basadas en lo que han aprendido.

- Cadenas: El componente de cadenas es como una serie de pasos que sigues para hacer algo. Por ejemplo, si estás horneando un pastel, sigues pasos como mezclar ingredientes, verter la masa y luego hornear. Las cadenas guían cómo se mueve la información a través de diferentes pasos para llegar a la respuesta final.

- Indicaciones: Estas son las preguntas o solicitudes que le das al modelo de lenguaje. Es como pedir ayuda a un amigo: si haces la pregunta correcta, obtendrás la respuesta correcta.

- Agentes: Imagina que los agentes son como tener un asistente personal que puede hacer tareas por ti. Los agentes son similares; pueden tomar medidas basadas en lo que les dices, como hacer reservas o enviar recordatorios, todo por su cuenta.

- Almacenes de vectores: Los componentes de los almacenes de vectores son lugares especiales para almacenar información para que sea fácil de encontrar cuando la necesites. Piensa en ellos como carpetas organizadas en tu computadora donde puedes buscar rápidamente un documento sin tener que buscar en un escritorio desordenado.

# Ejemplo de código: Creación de un agente de LangChain

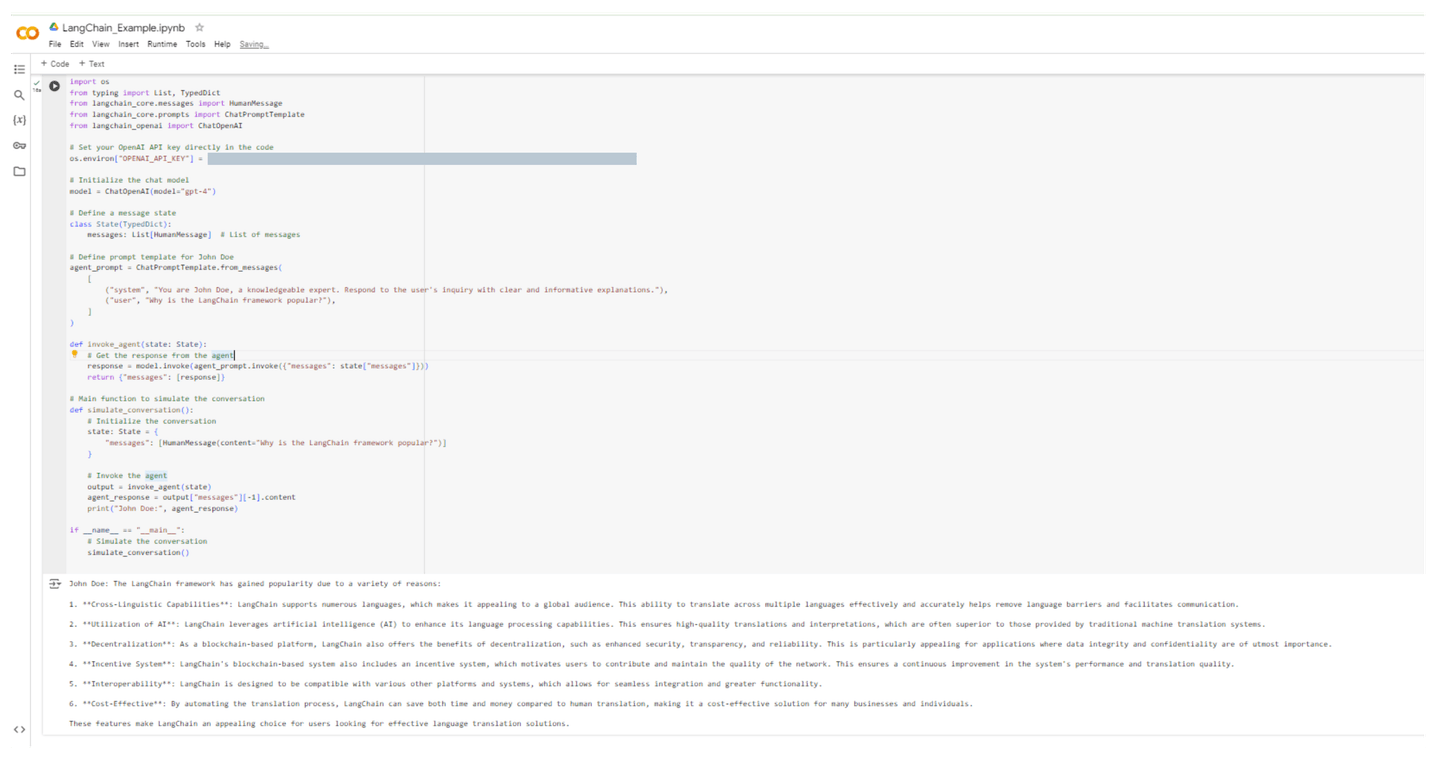

En el siguiente ejemplo, creamos un agente de LangChain llamado John Doe, quien explicará "¿Por qué es popular el marco de LangChain?" El código se muestra a continuación:

import os

from typing import List, TypedDict

from langchain_core.messages import HumanMessage

from langchain_core.prompts import ChatPromptTemplate

from langchain_openai import ChatOpenAI

# Establece tu clave de API de OpenAI directamente en el código

os.environ["OPENAI_API_KEY"] = "[CLAVE DE API DE OPENAI]"

# Inicializa el modelo de chat

model = ChatOpenAI(model="gpt-4")

# Define un estado de mensaje

class State(TypedDict):

messages: List[HumanMessage] # Lista de mensajes

# Define una plantilla de indicación para John Doe

agent_prompt = ChatPromptTemplate.from_messages(

[

("system", "Eres John Doe, un experto conocedor. Responde a la consulta del usuario con explicaciones claras e informativas."),

("user", "¿Por qué es popular el marco de LangChain?"),

]

)

def invoke_agent(state: State):

# Obtén la respuesta del agente

response = model.invoke(agent_prompt.invoke({"messages": state["messages"]}))

return {"messages": [response]}

# Función principal para simular la conversación

def simulate_conversation():

# Inicializa la conversación

state: State = {

"messages": [HumanMessage(content="¿Por qué es popular el marco de LangChain?")]

}

# Invoca al agente

output = invoke_agent(state)

agent_response = output["messages"][-1].content

print("John Doe:", agent_response)

if __name__ == "__main__":

# Simula la conversación

simulate_conversation()

Después de ejecutar este código, veamos la respuesta de John Doe:

John Doe: El marco de LangChain se ha vuelto popular debido a varias razones:

1. **Capacidades interlingüísticas**: LangChain admite numerosos idiomas, lo que lo hace atractivo para una audiencia global. Esta capacidad de traducir entre múltiples idiomas de manera efectiva y precisa ayuda a eliminar barreras lingüísticas y facilita la comunicación.

2. **Utilización de IA**: LangChain aprovecha la inteligencia artificial (IA) para mejorar sus capacidades de procesamiento de lenguaje. Esto garantiza traducciones e interpretaciones de alta calidad, que a menudo son superiores a las proporcionadas por los sistemas tradicionales de traducción automática.

3. **Descentralización**: Como plataforma basada en blockchain, LangChain también ofrece los beneficios de la descentralización, como una mayor seguridad, transparencia y confiabilidad. Esto es particularmente atractivo para aplicaciones donde la integridad y la confidencialidad de los datos son de suma importancia.

4. **Sistema de incentivos**: El sistema basado en blockchain de LangChain también incluye un sistema de incentivos, que motiva a los usuarios a contribuir y mantener la calidad de la red. Esto garantiza una mejora continua en el rendimiento del sistema y la calidad de la traducción.

5. **Interoperabilidad**: LangChain está diseñado para ser compatible con varias otras plataformas y sistemas, lo que permite una integración sin problemas y una mayor funcionalidad.

6. **Rentabilidad**: Al automatizar el proceso de traducción, LangChain puede ahorrar tiempo y dinero en comparación con la traducción humana, lo que lo convierte en una solución rentable para muchas empresas y particulares.

Estas características hacen de LangChain una opción atractiva para los usuarios que buscan soluciones efectivas de traducción de idiomas.

La siguiente captura de pantalla ilustra la ejecución de este código en un entorno de Colab:

Ahora que tenemos una comprensión clara de LangChain, pasemos a nuestro próximo marco.

# ¿Qué es AutoGen?

AutoGen es un marco que se centra más en automatizar los procesos de generación de código y la gestión de flujos de trabajo utilizando modelos de lenguaje grandes. Su objetivo principal es acelerar el proceso de desarrollo al permitir a los usuarios generar código funcional y automatizar tareas repetitivas a través de la entrada de lenguaje natural. AutoGen es ideal para prototipos rápidos, lo que permite a los usuarios crear aplicaciones y flujos de trabajo sin tener un amplio conocimiento de programación.

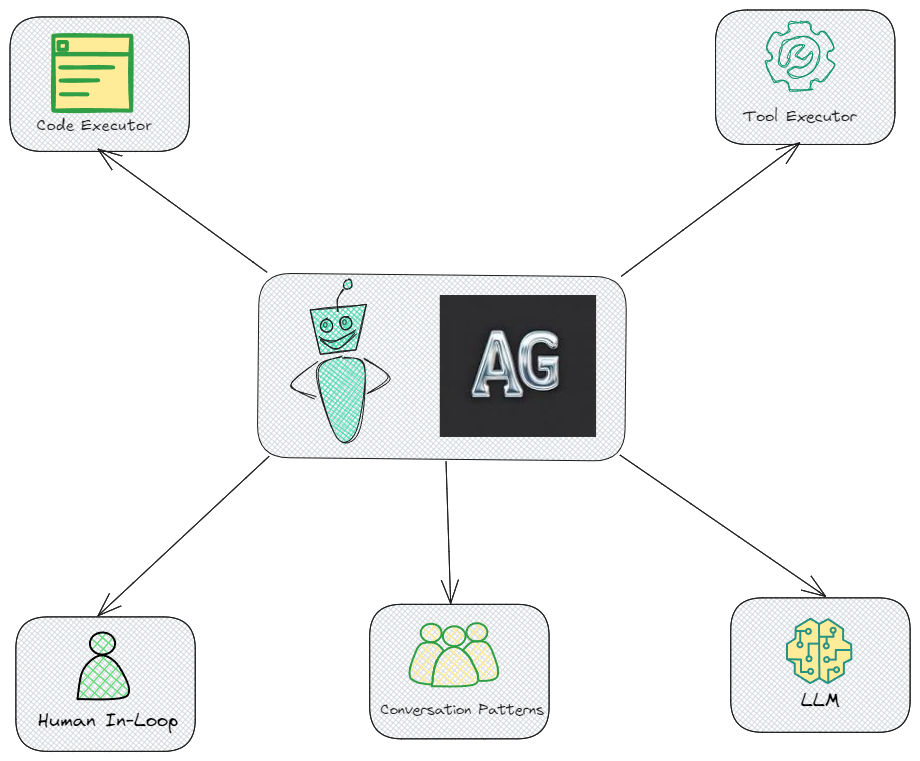

# Componentes de AutoGen

La siguiente ilustración muestra todos los componentes clave de AutoGen, mostrando cómo interactúan entre sí:

- Ejecutor de código: Este componente permite que AutoGen ejecute código automáticamente. Esta es una función fundamental que permite a los agentes ejecutar código en función de los objetivos establecidos.

- Ejecutor de herramientas: Este componente es esencial para AutoGen, ya que permite que el sistema interactúe con varias herramientas externas o API.

- Intervención humana: Esto es importante en casos donde se requiere intervención humana para la toma de decisiones o validación, asegurando que los operadores humanos puedan guiar o controlar a los agentes cuando sea necesario.

- Patrones de conversación: Esto sugiere que AutoGen incorpora estructuras de conversación predefinidas para gestionar las interacciones de los agentes de manera efectiva. Es un elemento esencial para garantizar un diálogo coherente y dirigido por objetivos entre los agentes.

- LLM (Modelo de Lenguaje Grande): Los LLM son de hecho una parte clave de la arquitectura de AutoGen, proporcionando las capacidades lingüísticas subyacentes que impulsan la comprensión y la toma de decisiones de los agentes.

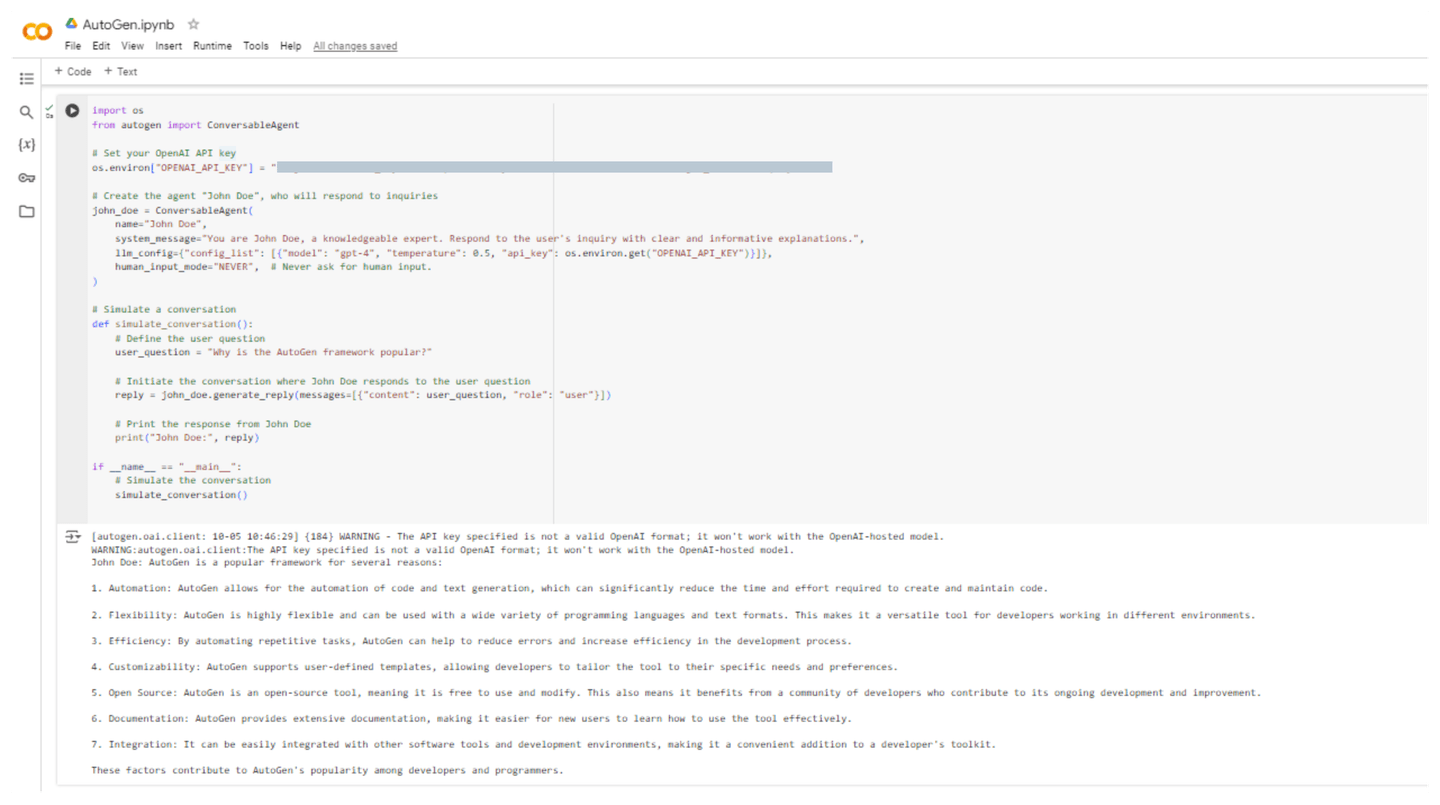

# Ejemplo de código: Creación de un agente de AutoGen

Ahora creemos el mismo agente John Doe en AutoGen, quien explicará "¿Por qué es popular el marco de AutoGen?" El código se muestra a continuación:

import os

from autogen import ConversableAgent

# Establece tu clave de API de OpenAI

os.environ["OPENAI_API_KEY"] = "[CLAVE DE API DE OPENAI]"

# Crea el agente "John Doe", quien responderá a las consultas

john_doe = ConversableAgent(

name="John Doe",

system_message="Eres John Doe, un experto conocedor. Responde a la consulta del usuario con explicaciones claras e informativas.",

llm_config={"config_list": [{"model": "gpt-4", "temperature": 0.5, "api_key": os.environ.get("OPENAI_API_KEY")}]},

human_input_mode="NEVER", # Nunca solicitar entrada humana.

)

# Simula una conversación

def simulate_conversation():

# Define la pregunta del usuario

user_question = "¿Por qué es popular el marco de AutoGen?"

# Inicia la conversación donde John Doe responde a la pregunta del usuario

reply = john_doe.generate_reply(messages=[{"content": user_question, "role": "user"}])

# Imprime la respuesta de John Doe

print("John Doe:", reply)

if __name__ == "__main__":

# Simula la conversación

simulate_conversation()

Después de ejecutar este código, John Doe da respuestas con la siguiente explicación:

John Doe: AutoGen es un marco popular por varias razones:

1. Automatización: AutoGen permite la automatización de la generación de código y texto, lo que puede reducir significativamente el tiempo y el esfuerzo requeridos para crear y mantener el código.

2. Flexibilidad: AutoGen es altamente flexible y se puede utilizar con una amplia variedad de lenguajes de programación y formatos de texto. Esto lo convierte en una herramienta versátil para desarrolladores que trabajan en diferentes entornos.

3. Eficiencia: Al automatizar tareas repetitivas, AutoGen puede ayudar a reducir errores y aumentar la eficiencia en el proceso de desarrollo.

4. Personalización: AutoGen admite plantillas definidas por el usuario, lo que permite a los desarrolladores adaptar la herramienta a sus necesidades y preferencias específicas.

5. Código abierto: AutoGen es una herramienta de código abierto, lo que significa que es gratuita y se puede modificar. Esto también significa que se beneficia de una comunidad de desarrolladores que contribuyen a su desarrollo y mejora continua.

6. Documentación: AutoGen proporciona una documentación extensa, lo que facilita a los nuevos usuarios aprender a utilizar la herramienta de manera efectiva.

7. Integración: Se puede integrar fácilmente con otras herramientas de software y entornos de desarrollo, lo que lo convierte en una adición conveniente al conjunto de herramientas de un desarrollador.

Estos factores contribuyen a la popularidad de AutoGen entre los desarrolladores y programadores.

La siguiente captura de pantalla ilustra la ejecución de este código en un entorno de Colab:

# LangChain vs. AutoGen: Una visión comparativa

Aquí tienes una tabla de comparación que describe las diferencias y similitudes clave entre LangChain y AutoGen. Esta tabla te ayudará a comprender las características únicas, fortalezas y casos de uso previstos para cada marco.

| Característica / Aspecto | LangChain | AutoGen |

|---|---|---|

| Propósito | Marco para desarrollar aplicaciones utilizando modelos de lenguaje, enfocándose en encadenar operaciones y flujo de datos. | Marco para habilitar flujos de trabajo complejos utilizando múltiples agentes que pueden comunicarse y colaborar. |

| Modelo de agente | Admite la construcción de agentes y flujos de trabajo personalizados. | Utiliza agentes conversacionales que pueden enviar y recibir mensajes, simplificando las interacciones multiagente. |

| Comunidad | Comunidad establecida con documentación y ejemplos extensos. | Comunidad en crecimiento con desarrollo activo y enfoque en la investigación. |

| Flujos de trabajo complejos | Puede construir flujos de trabajo complejos, pero principalmente a través de la encadenación de operaciones. | Diseñado para flujos de trabajo complejos con múltiples agentes, facilitando la interacción entre ellos. |

| Facilidad de uso | Sencillo para aquellos familiarizados con LLM, pero puede tener una curva de aprendizaje para principiantes. | Fácil de usar para construir sistemas multiagente, enfocándose en la colaboración y la comunicación. |

| Casos de uso | Ideal para aplicaciones de procesamiento de datos, generación de contenido y agentes conversacionales. | Adecuado para aplicaciones que requieren sistemas multiagente, como debates, atención al cliente o resolución colaborativa de problemas. |

| Integración | Se integra bien con varios LLM, herramientas y servicios externos. | Diseñado específicamente para la integración de agentes y sus componentes, incluida la entrada humana. |

| Intervención humana | Soporte limitado para la participación humana; se centra más en la automatización. | Admite escenarios de intervención humana, permitiendo que los agentes busquen la entrada humana cuando sea necesario. |

| Uso de API | Requiere una clave de API para LLM como OpenAI, pero se centra menos en las interacciones entre agentes. | Requiere una clave de API para LLM, diseñado específicamente para interacciones y flujos de trabajo de agentes. |

| Modelos admitidos | Funciona con una variedad de modelos, incluidos GPT-3, GPT-4 y otros. | Se integra principalmente con modelos de OpenAI, pero se puede ampliar para admitir otros modelos también. |

Esta tabla proporciona una visión general rápida de las fortalezas y consideraciones tanto de LangChain como de AutoGen, lo que te ayudará a decidir qué herramienta se adapta mejor a las necesidades de tu proyecto.

# Conclusión

LangChain y AutoGen son marcos robustos diseñados para diversos propósitos dentro del campo de la inteligencia artificial. LangChain se especializa en la creación de aplicaciones organizadas que utilizan modelos de lenguaje mediante componentes modulares y encadenamiento de flujos de trabajo. Esto lo hace perfecto para tareas como el procesamiento de datos y la generación de contenido. Por otro lado, AutoGen se destaca en el desarrollo de sistemas interactivos con múltiples agentes que pueden trabajar juntos y comunicarse de manera eficiente para abordar tareas difíciles, lo que facilita la participación humana en la resolución de problemas.

Al combinar MyScale (opens new window) con ambos marcos, la funcionalidad mejora considerablemente, ya que permite un almacenamiento y recuperación efectivos de incrustaciones vectoriales. Esta integración facilita la rápida recuperación de información pertinente, mejorando la adecuación del contexto y la precisión de las respuestas en las aplicaciones. Además, el algoritmo MSTG (opens new window) de MyScale optimiza las operaciones de búsqueda y recuperación para el manejo eficiente de grandes conjuntos de datos. Colaborativamente, estas herramientas permiten a los desarrolladores construir plataformas sólidas y eficientes basadas en IA.