近年、人工知能(AI) (opens new window)は特に大規模言語モデル(LLM) (opens new window)の領域で大きな変革を遂げています。OpenAIのGPTシリーズ、GoogleのGemini、MetaのLLaMAなどのモデルは、人間の文章にほぼ似たテキストを生成するなど、驚くべき能力を示しています。これにより、コンテンツの作成や言語の翻訳から複雑な問題の解決やビジネスプロセスの改善まで、さまざまなタスクで非常に有用です。

LLMは、過去に手作業が必要だったタスクを処理するのに役立ち、より迅速な結果をもたらし、AIパワードソリューションの新たな可能性を開拓します。ユニークなAIソリューションへの需要の増加に伴い、開発者がAIアプリケーションをより簡単に構築するためのさまざまなツールが既に開発されています。最も人気のある2つの技術はLangChain (opens new window)とAutoGen (opens new window)です。このブログ記事では、これら2つのフレームワークを詳しく見て、それぞれが提供するものとその違いを理解します。

# LangChainとは?

LangChainは、モジュラーで拡張可能なパイプラインの作成を可能にすることで、大規模言語モデル(LLM)ベースのアプリケーションの開発を容易にするために設計されたフレームワークです。これにより、開発者はプロンプト、メモリ、外部APIなどのさまざまなコンポーネントをバランスの取れたアプリケーションに統合することができます。この機能により、洗練された対話エージェント、データ検索システム、その他のLLMベースのアプリケーションの構築に特に適しています。

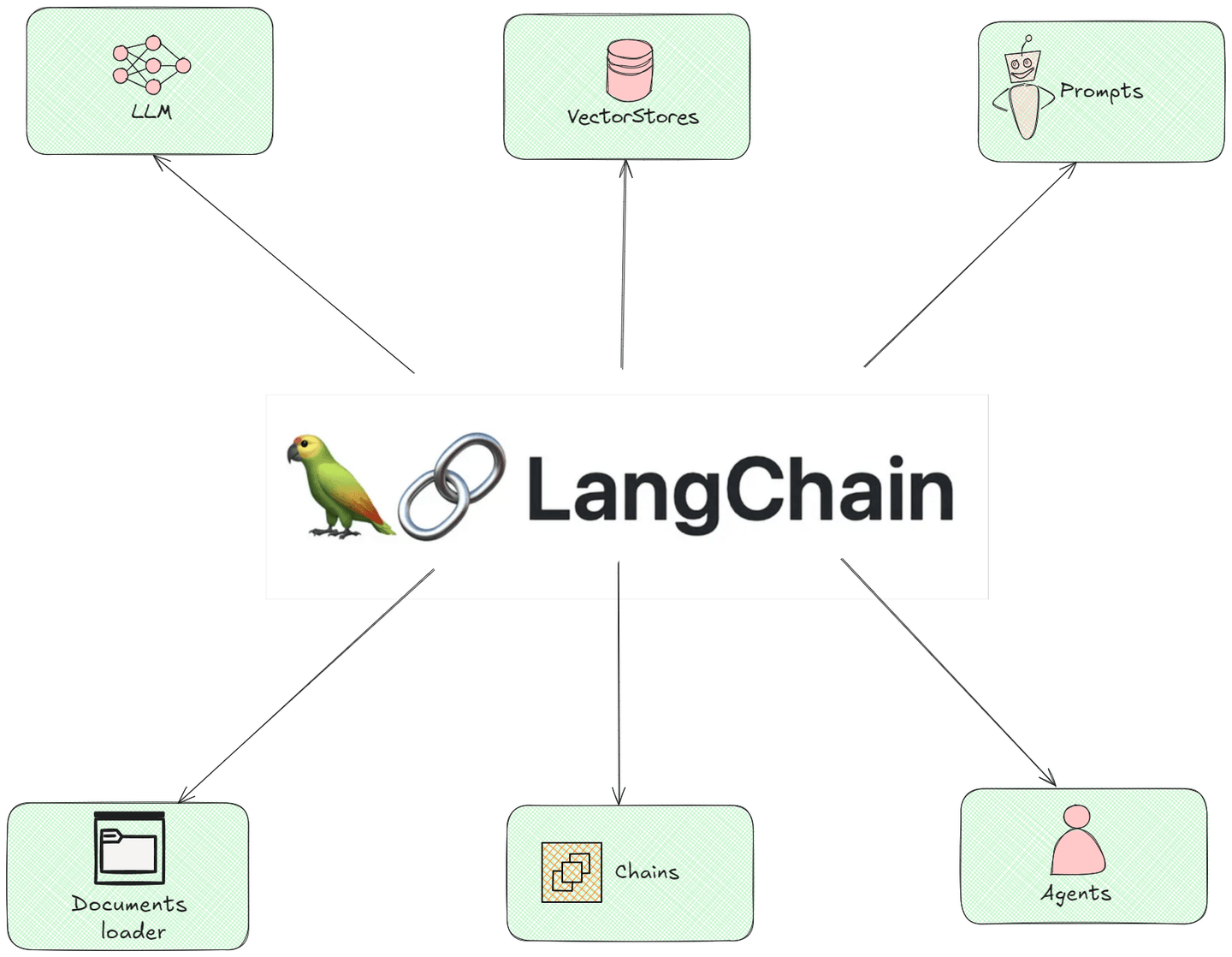

# LangChainのコンポーネント

次の図は、LangChainのすべてのモジュラーコンポーネントを示し、それらがどのように相互作用するかを示しています。

- ドキュメントローダー: このコンポーネントは、インターネット上のさまざまな場所から情報を収集するヘルパーとして機能します。料理を始める前に必要な材料を集めるイメージです。

- LLM(言語モデル): このコンポーネントは、賢いロボットのようなもので、文章を書いたり質問に答えたりすることができます。彼らはたくさんの情報を読んでいるので、学んだことに基づいて良い回答をすることができます。

- チェーン: チェーンコンポーネントは、何かを成し遂げるための一連の手順のようなものです。たとえば、ケーキを焼く場合、材料を混ぜる、生地を流し込む、焼くなどの手順に従います。チェーンは、情報が異なるステップを経て最終的な回答に到達する方法を指示します。

- プロンプト: これは言語モデルに与える質問やリクエストです。友達に助けを求めるようなものです。適切な質問をすると、適切な回答が得られます。

- エージェント: エージェントは、あなたのためにタスクを実行できる個人のアシスタントのようなものです。エージェントも同様で、あなたが伝えたことに基づいてアクションを起こすことができます。予約を作成したり、リマインダーを送信したりすることができます。

- ベクトルストア: ベクトルストアコンポーネントは、情報を簡単に見つけるための特別な場所です。パソコンの整理されたフォルダのようなもので、散らかったデスクトップを探し回らずにすばやくドキュメントを探すことができます。

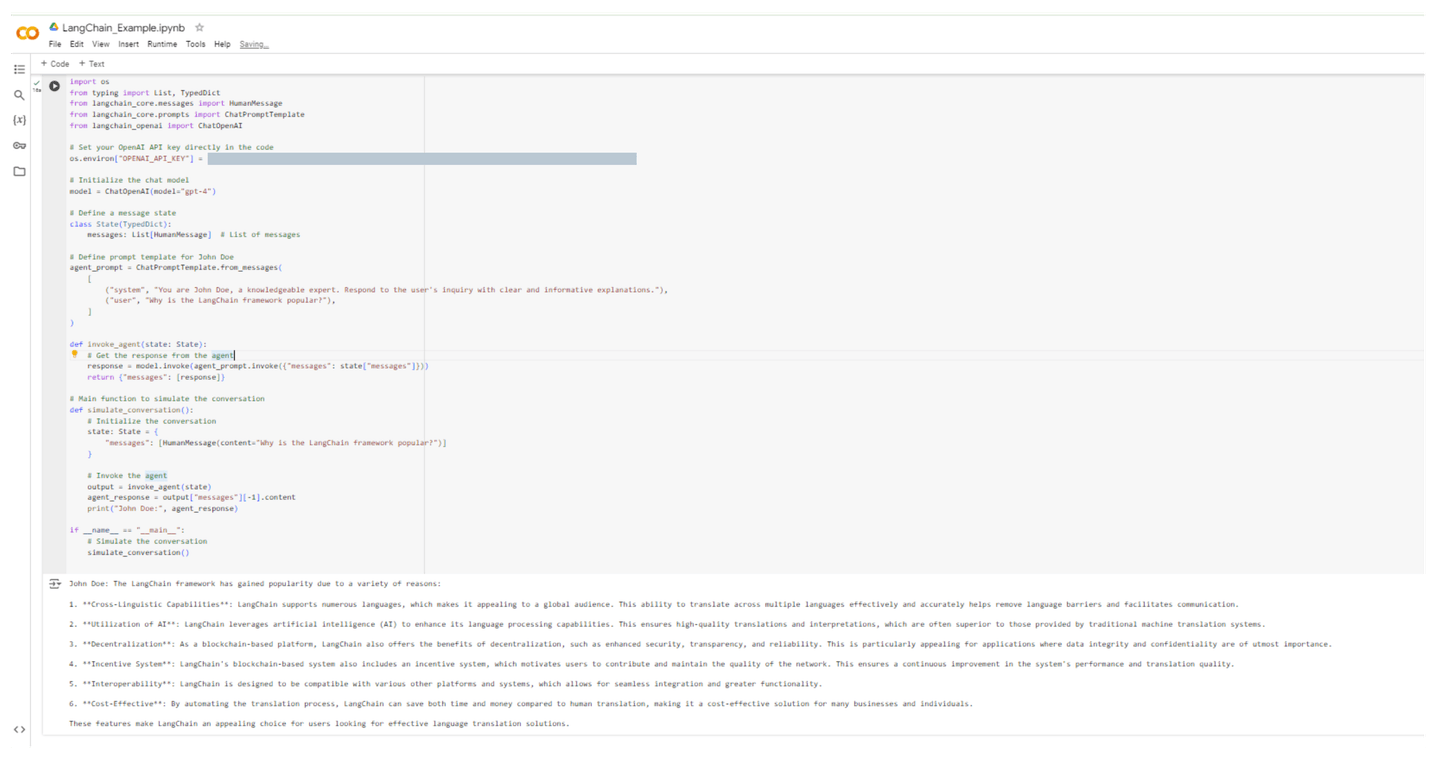

# コーディング例:LangChainエージェントの作成

次の例では、LangChainエージェントの名前をJohn Doeとし、**「なぜLangChainフレームワークが人気なのか?」**と説明します。コードは以下の通りです。

import os

from typing import List, TypedDict

from langchain_core.messages import HumanMessage

from langchain_core.prompts import ChatPromptTemplate

from langchain_openai import ChatOpenAI

# コード内でOpenAI APIキーを設定

os.environ["OPENAI_API_KEY"] = "[OPENAI API KEY]"

# チャットモデルの初期化

model = ChatOpenAI(model="gpt-4")

# メッセージの状態を定義

class State(TypedDict):

messages: List[HumanMessage] # メッセージのリスト

# John Doeのプロンプトテンプレートを定義

agent_prompt = ChatPromptTemplate.from_messages(

[

("system", "You are John Doe, a knowledgeable expert. Respond to the user's inquiry with clear and informative explanations."),

("user", "Why is the LangChain framework popular?"),

]

)

def invoke_agent(state: State):

# エージェントからの応答を取得

response = model.invoke(agent_prompt.invoke({"messages": state["messages"]}))

return {"messages": [response]}

# 会話をシミュレートするメイン関数

def simulate_conversation():

# 会話を初期化

state: State = {

"messages": [HumanMessage(content="Why is the LangChain framework popular?")]

}

# エージェントを呼び出す

output = invoke_agent(state)

agent_response = output["messages"][-1].content

print("John Doe:", agent_response)

if __name__ == "__main__":

# 会話をシミュレート

simulate_conversation()

このコードを実行した後、John Doeの回答を見てみましょう。

John Doe: LangChainフレームワークは、さまざまな理由から人気があります:

1. **クロス言語対応**: LangChainは多数の言語をサポートしており、グローバルなユーザーに魅力的です。複数の言語間で効果的かつ正確に翻訳する能力は、言語の壁を取り除き、コミュニケーションを円滑にします。

2. **AIの活用**: LangChainは人工知能(AI)を活用して言語処理能力を向上させています。これにより、従来の機械翻訳システムよりも優れた品質の翻訳や解釈が可能となります。

3. **分散化**: ブロックチェーンベースのプラットフォームであるLangChainは、セキュリティ、透明性、信頼性などの分散化の利点も提供しています。これは、データの整合性と機密性が最も重要なアプリケーションに特に魅力的です。

4. **インセンティブシステム**: LangChainのブロックチェーンベースのシステムには、ユーザーがネットワークの品質を向上させるために貢献し、維持することを促すインセンティブシステムも含まれています。これにより、システムのパフォーマンスと翻訳品質の持続的な改善が保証されます。

5. **相互運用性**: LangChainは、さまざまな他のプラットフォームやシステムと互換性があります。これにより、シームレスな統合とより高度な機能が実現できます。

6. **コスト効果**: 翻訳プロセスを自動化することで、LangChainは人間の翻訳と比べて時間とコストを節約できます。多くのビジネスや個人にとって、費用対効果の高いソリューションとなります。

これらの特徴により、LangChainは効果的な言語翻訳ソリューションを求めるユーザーにとって魅力的な選択肢となっています。

次のスクリーンショットは、このコードをColab環境で実行したものです。

LangChainの理解が明確になったので、次のフレームワークに進みましょう。

# AutoGenとは?

AutoGenは、大規模言語モデルを使用してコード生成プロセスとワークフロー管理を自動化することにより、開発プロセスを高速化することに重点を置いたフレームワークです。ユーザーは自然言語入力を通じて機能的なコードを生成し、繰り返しのタスクを自動化することができます。AutoGenは、広範なプログラミング知識なしでアプリケーションやワークフローを迅速に作成できるため、ラピッドプロトタイピングに最適です。

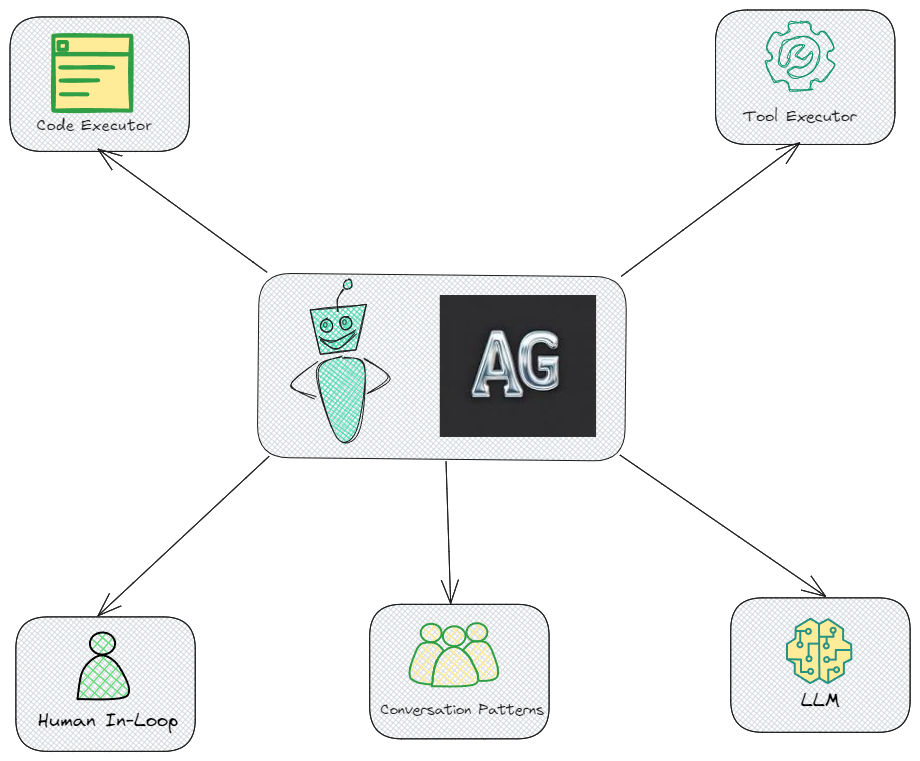

# AutoGenのコンポーネント

次の図は、AutoGenのすべての主要なコンポーネントを示し、それらがどのように相互作用するかを示しています。

- コードエグゼキュータ - このコンポーネントにより、AutoGenはコードを自動的に実行できます。エージェントが設定した目標に基づいてコードを実行するための重要な機能です。

- ツールエグゼキュータ - このコンポーネントもAutoGenにとって重要であり、システムがさまざまな外部ツールやAPIと対話できるようにします。

- ヒューマンインループ - これは、意思決定や検証に人間の介入が必要な場合に重要です。人間オペレーターがエージェントをガイドしたり制御したりできるようにします。

- 会話パターン - これは、AutoGenがエージェント間の効果的な対話を管理するために事前に定義された会話構造を組み込むことを示しています。エージェント間の一貫した目標指向の対話を確保するために重要な要素です。

- LLM(大規模言語モデル) - LLMはAutoGenのアーキテクチャの重要な部分であり、エージェントの理解と意思決定を駆動する基本的な言語機能を提供します。

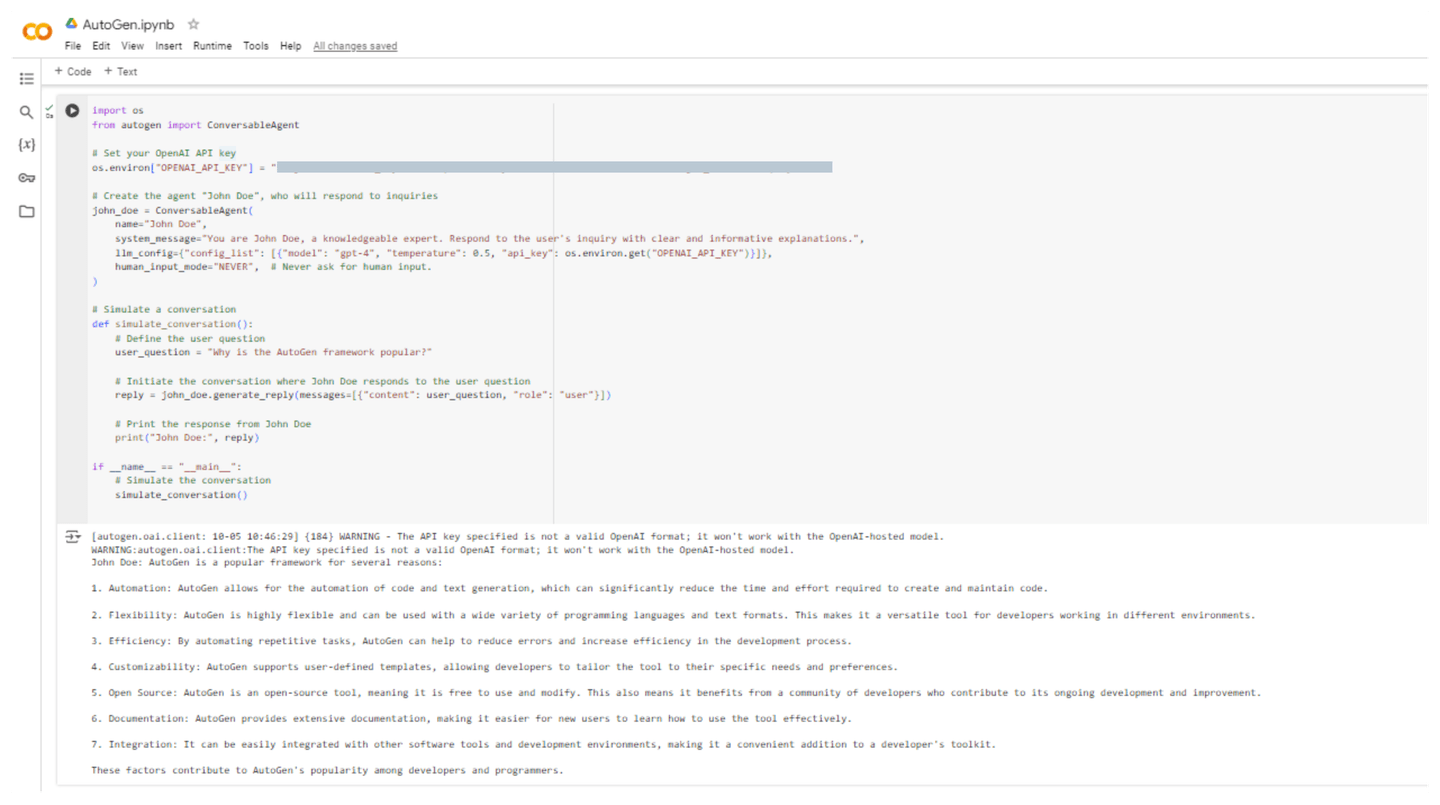

# コーディング例:AutoGenエージェントの作成

次に、AutoGenで同じJohn Doeエージェントを作成し、**「なぜAutoGenフレームワークが人気なのか?」**と説明します。コードは以下の通りです。

import os

from autogen import ConversableAgent

# OpenAI APIキーを設定

os.environ["OPENAI_API_KEY"] = "[OPENAI API KEY]"

# 問い合わせに応答するエージェント「John Doe」を作成

john_doe = ConversableAgent(

name="John Doe",

system_message="You are John Doe, a knowledgeable expert. Respond to the user's inquiry with clear and informative explanations.",

llm_config={"config_list": [{"model": "gpt-4", "temperature": 0.5, "api_key": os.environ.get("OPENAI_API_KEY")}]},

human_input_mode="NEVER", # ヒューマンインプットを求めない

)

# 会話をシミュレート

def simulate_conversation():

# ユーザーの質問を定義

user_question = "Why is the AutoGen framework popular?"

# John Doeがユーザーの質問に応答する会話を開始

reply = john_doe.generate_reply(messages=[{"content": user_question, "role": "user"}])

# John Doeからの応答を表示

print("John Doe:", reply)

if __name__ == "__main__":

# 会話をシミュレート

simulate_conversation()

このコードを実行した後、John Doeが以下の説明とともに回答をします。

John Doe: AutoGenは、次の理由で人気のあるフレームワークです:

1. 自動化:AutoGenはコードとテキストの生成を自動化することができ、コードの作成とメンテナンスに必要な時間と労力を大幅に削減できます。

2. 柔軟性:AutoGenは非常に柔軟で、さまざまなプログラミング言語やテキスト形式と組み合わせて使用することができます。これにより、さまざまな環境で作業する開発者にとって、多目的なツールとなります。

3. 効率性:繰り返しのタスクを自動化することで、AutoGenはエラーを減らし、開発プロセスの効率を向上させるのに役立ちます。

4. カスタマイズ性:AutoGenはユーザー定義のテンプレートをサポートしており、ツールを特定のニーズや好みに合わせることができます。

5. オープンソース:AutoGenはオープンソースのツールであり、無料で使用および変更することができます。また、開発と改善に貢献する開発者コミュニティの恩恵も受けています。

6. ドキュメンテーション:AutoGenは包括的なドキュメンテーションを提供しており、新しいユーザーが効果的にツールを学ぶのを容易にしています。

7. 統合:他のソフトウェアツールや開発環境と簡単に統合できるため、開発者のツールキットに便利な追加となります。

これらの要素が、AutoGenの開発者やプログラマーの間で人気を博しています。

次のスクリーンショットは、このコードをColab環境で実行したものです。

# LangChain vs AutoGen:比較的な概要

以下の表は、LangChainとAutoGenの主な違いと類似点を示しています。この表を使用すると、それぞれのフレームワークのユニークな機能、強み、および想定されるユースケースを理解するのに役立ちます。

| 機能/側面 | LangChain | AutoGen |

|---|---|---|

| 目的 | 言語モデルを使用したアプリケーションの開発のためのフレームワークで、操作とデータフローのチェーンに焦点を当てています。 | 複数のエージェントがコミュニケーションし協力できる複雑なワークフローを可能にするフレームワークです。 |

| エージェントモデル | カスタムエージェントとワークフローの構築をサポートしています。 | メッセージの送受信ができる会話エージェントを使用し、マルチエージェントの相互作用を簡素化しています。 |

| コミュニティ | 包括的なドキュメンテーションと例を備えた確立されたコミュニティです。 | 開発と研究に焦点を当てた成長中のコミュニティです。 |

| 複雑なワークフロー | 複雑なワークフローを構築できますが、主に操作のチェーンを通じて行います。 | 複数のエージェントを使用した複雑なワークフローに特化しており、それらの間の相互作用を容易にします。 |

| 使いやすさ | LLMに精通している人にとっては直感的ですが、初心者には学習曲線があるかもしれません。 | マルチエージェントシステムの構築に向けたユーザーフレンドリーな設計で、協力とコミュニケーションに重点を置いています。 |

| ユースケース | データ処理、コンテンツ生成、対話エージェントなどのアプリケーションに最適です。 | ディベート、カスタマーサポート、協力的な問題解決など、複数のエージェントシステムを必要とするアプリケーションに適しています。 |

| 統合 | さまざまなLLM、ツール、外部サービスとの統合がうまく行われます。 | エージェントとそのコンポーネント(ヒューマンインプットを含む)の統合に特化しています。 |

| ヒューマンインループ | ヒューマンの関与をサポートする機能が限られており、主に自動化に重点を置いています。 | エージェントが必要な場合にヒューマンの入力を求めることができるヒューマンインループのシナリオをサポートしています。 |

| APIの使用 | OpenAIなどのLLMにAPIキーが必要ですが、エージェント間の相互作用にはあまり焦点を当てていません。 | LLMにAPIキーが必要であり、エージェント間の相互作用とワークフローに特化しています。 |

| サポートされるモデル | GPT-3、GPT-4など、さまざまなモデルと連携します。 | 主にOpenAIモデルと連携し、他のモデルもサポートするために拡張できます。 |

この表は、LangChainとAutoGenの強みと考慮事項を簡単に把握するのに役立ちます。プロジェクトのニーズに最適なツールを選択するのに役立ちます。

# 結論

LangChainとAutoGenは、人工知能の分野でさまざまな目的に向けて設計された堅牢なフレームワークです。LangChainは、モジュラーコンポーネントとワークフローチェーンを使用して言語モデルを活用する整理されたアプリケーションを作成することに特化しており、データ処理やコンテンツ生成などのタスクに最適です。一方、AutoGenは、複数のエージェントが協力して効率的にコミュニケーションし、困難なタスクに取り組むための対話システムの開発において優れた性能を発揮します。

MyScale (opens new window)をこれらのフレームワークと組み合わせることで、機能性が大幅に向上し、ベクトル埋め込みの効果的な保存と検索が可能になります。この統合により、関連する情報の迅速な検索と取得が可能となり、アプリケーションの文脈の適切性と回答の正確性が向上します。さらに、MyScaleのMSTGアルゴリズム (opens new window)により、効率的なデータセットの処理における検索と取得の操作が改善されます。これらのツールを共同で使用することで、開発者は強力で効率的なAIベースのプラットフォームを構築することができます。