近年来,人工智能(AI) (opens new window)在大型语言模型(LLM) (opens new window)领域取得了一些重大变革。这些模型,如OpenAI的 (opens new window)GPT系列、Google的Gemini (opens new window)和Meta的LLaMA (opens new window),展示了生成几乎与人类写作相似的文本的惊人能力。这使它们在从撰写内容和翻译语言到解决复杂问题和改进业务流程的各种任务中非常有用。

LLM可以帮助我们处理过去需要手动完成的任务,从而实现更快的结果,并为基于AI的解决方案开辟新的机会。随着对独特AI解决方案的需求不断增加,已经开发出了几种工具,以帮助开发人员更轻松地构建AI应用程序。其中最流行的两种技术是LangChain (opens new window)和AutoGen (opens new window)。在本博客文章中,我们将更详细地了解这两个框架,了解它们提供了什么以及它们之间的区别。

# 什么是LangChain?

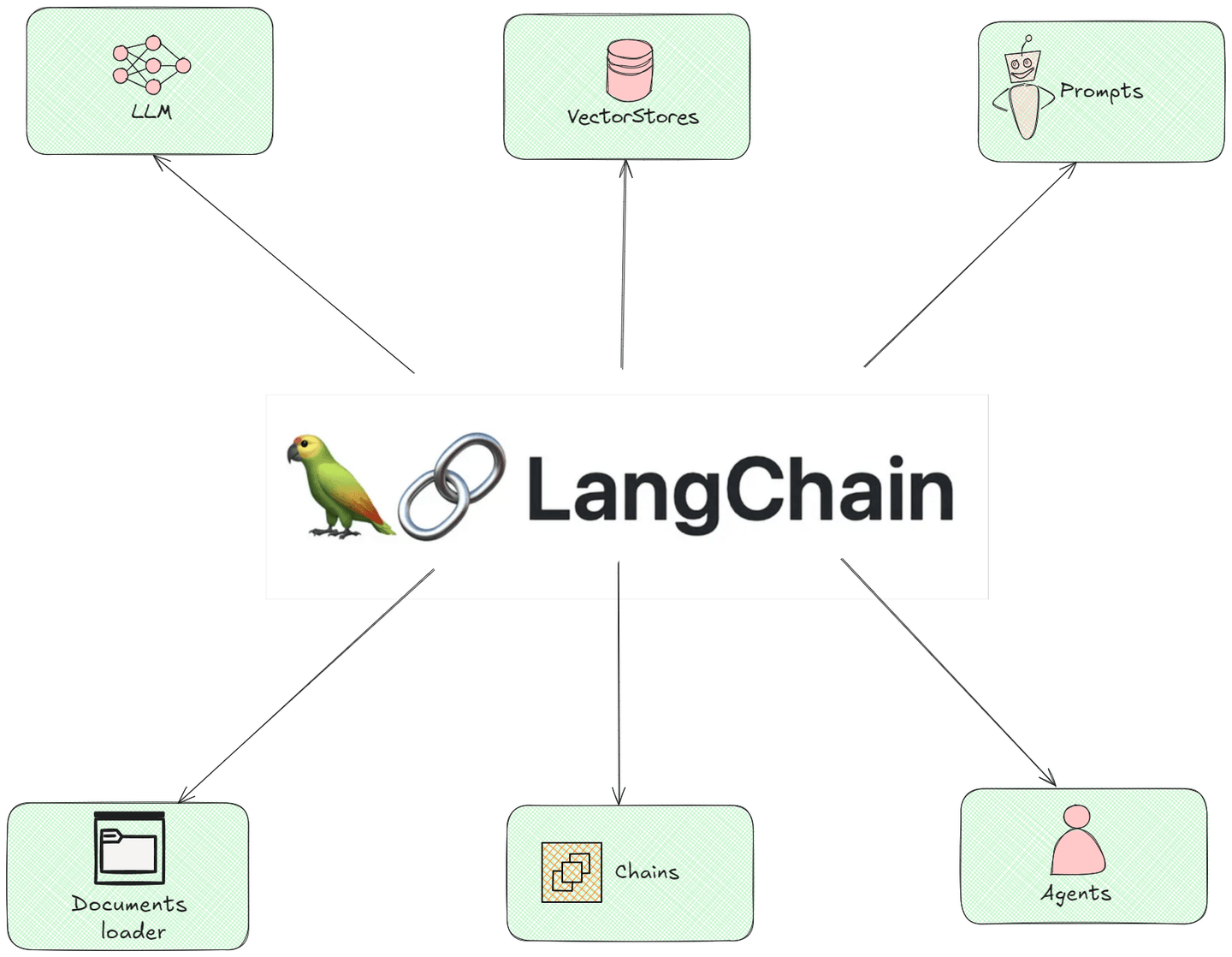

LangChain是一个旨在通过启用模块化和可扩展的流水线来促进大型语言模型(LLM)应用程序开发的框架。它允许开发人员将不同的组件(例如提示、内存和外部API)集成到一个平衡的应用程序中。这种能力使其特别适用于构建精细的对话代理、数据检索系统和其他基于LLM的应用程序。

# LangChain的组件

以下插图展示了LangChain的所有模块化组件,展示了它们如何相互交互:

- 文档加载器:该组件作为助手从互联网上的不同位置或您拥有的文件中收集信息。可以想象它们在开始烹饪之前收集您制作菜肴所需的所有配料。

- LLMs(语言模型):将此组件视为可以编写和回答问题的智能机器人。它们已经阅读了很多东西,因此可以根据他们所学到的知识给出好的答案。

- 链:链组件就像您按照一系列步骤完成某项任务。例如,如果您正在烘烤蛋糕,您会按照混合配料、倒入面糊,然后烘烤的步骤进行操作。链指导信息在不同步骤之间的传递,以得到最终答案。

- 提示:这些是您给语言模型的问题或请求。就像向朋友寻求帮助一样,如果您提出正确的问题,您将得到正确的答案!

- 代理:想象一下代理就像拥有可以为您执行任务的个人助理。代理类似;它们可以根据您告诉它们的内容采取行动,例如预订或发送提醒,所有这些都是它们自己完成的。

- 向量存储:向量存储组件是存储信息的特殊位置,因此在需要时可以轻松找到。将它们视为计算机上的有组织文件夹,您可以快速查找文档,而无需在杂乱的桌面上翻找。

# 代码示例:创建LangChain代理

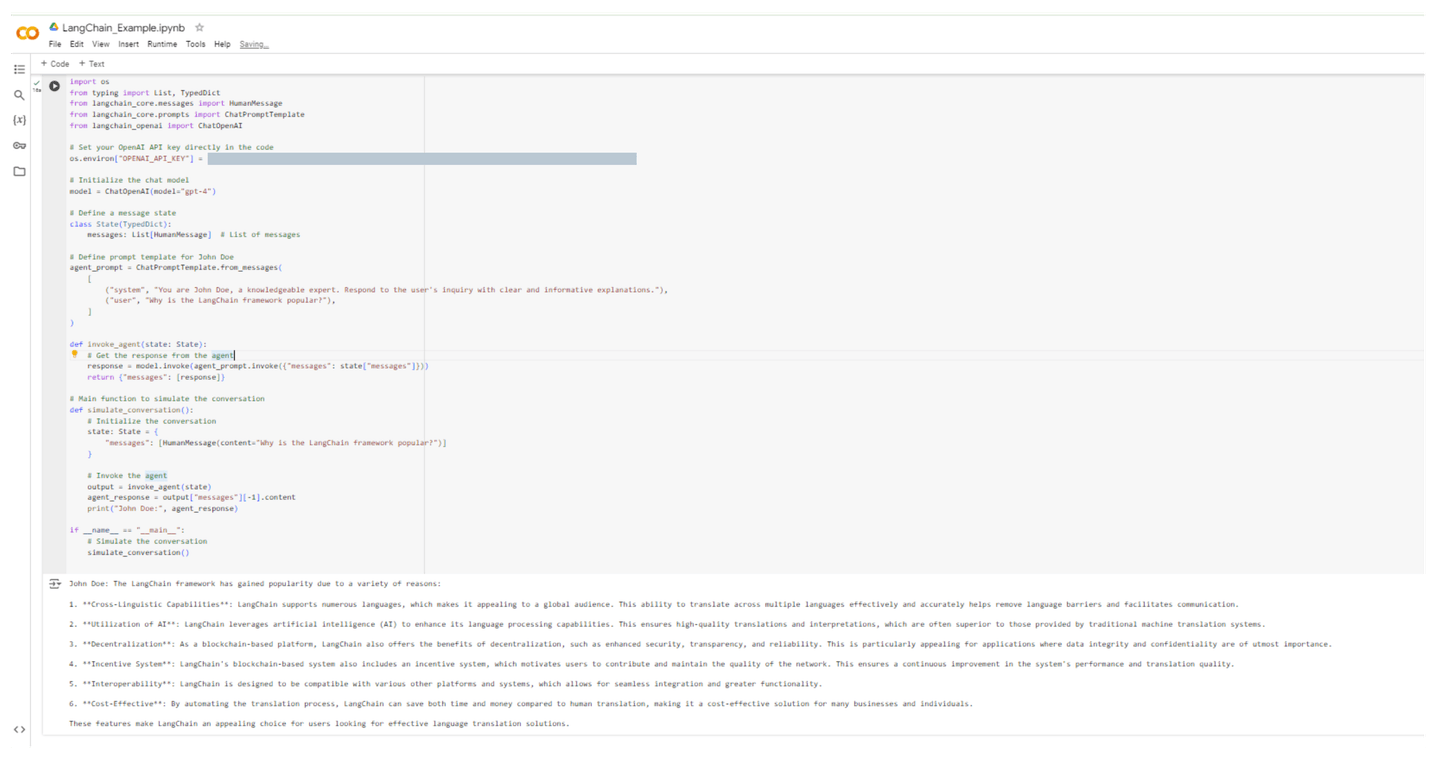

在以下示例中,我们创建了一个名为John Doe的LangChain代理,他将解释**“为什么LangChain框架受欢迎?”**代码如下所示:

import os

from typing import List, TypedDict

from langchain_core.messages import HumanMessage

from langchain_core.prompts import ChatPromptTemplate

from langchain_openai import ChatOpenAI

# 在代码中设置您的OpenAI API密钥

os.environ["OPENAI_API_KEY"] = "[OPENAI API KEY]"

# 初始化聊天模型

model = ChatOpenAI(model="gpt-4")

# 定义消息状态

class State(TypedDict):

messages: List[HumanMessage] # 消息列表

# 为John Doe定义提示模板

agent_prompt = ChatPromptTemplate.from_messages(

[

("system", "You are John Doe, a knowledgeable expert. Respond to the user's inquiry with clear and informative explanations."),

("user", "Why is the LangChain framework popular?"),

]

)

def invoke_agent(state: State):

# 从代理获取响应

response = model.invoke(agent_prompt.invoke({"messages": state["messages"]}))

return {"messages": [response]}

# 模拟对话的主要函数

def simulate_conversation():

# 初始化对话

state: State = {

"messages": [HumanMessage(content="Why is the LangChain framework popular?")]

}

# 调用代理

output = invoke_agent(state)

agent_response = output["messages"][-1].content

print("John Doe:", agent_response)

if __name__ == "__main__":

# 模拟对话

simulate_conversation()

执行此代码后,让我们看看John Doe的回答:

John Doe: LangChain框架之所以受欢迎,有以下几个原因:

1. **跨语言能力**:LangChain支持多种语言,这使其对全球受众具有吸引力。它能够有效准确地在多种语言之间进行翻译,有助于消除语言障碍并促进沟通。

2. **利用人工智能**:LangChain利用人工智能(AI)增强其语言处理能力。这确保了高质量的翻译和解释,通常优于传统机器翻译系统提供的翻译质量。

3. **去中心化**:作为基于区块链的平台,LangChain还提供了去中心化的优势,例如增强的安全性、透明性和可靠性。这对于数据完整性和机密性至关重要的应用特别有吸引力。

4. **激励系统**:LangChain的基于区块链的系统还包括激励系统,鼓励用户贡献和维护网络的质量。这确保了系统性能和翻译质量的持续改进。

5. **互操作性**:LangChain设计为与各种其他平台和系统兼容,这允许无缝集成和更大的功能性。

6. **成本效益**:通过自动化翻译过程,LangChain可以节省时间和金钱,相比人工翻译,使其成为许多企业和个人的经济有效解决方案。

这些特点使LangChain成为寻求有效的语言翻译解决方案的用户的理想选择。

以下屏幕截图展示了在Colab环境中执行此代码的情况:

现在我们对LangChain有了清晰的了解,让我们继续下一个框架。

# 什么是AutoGen?

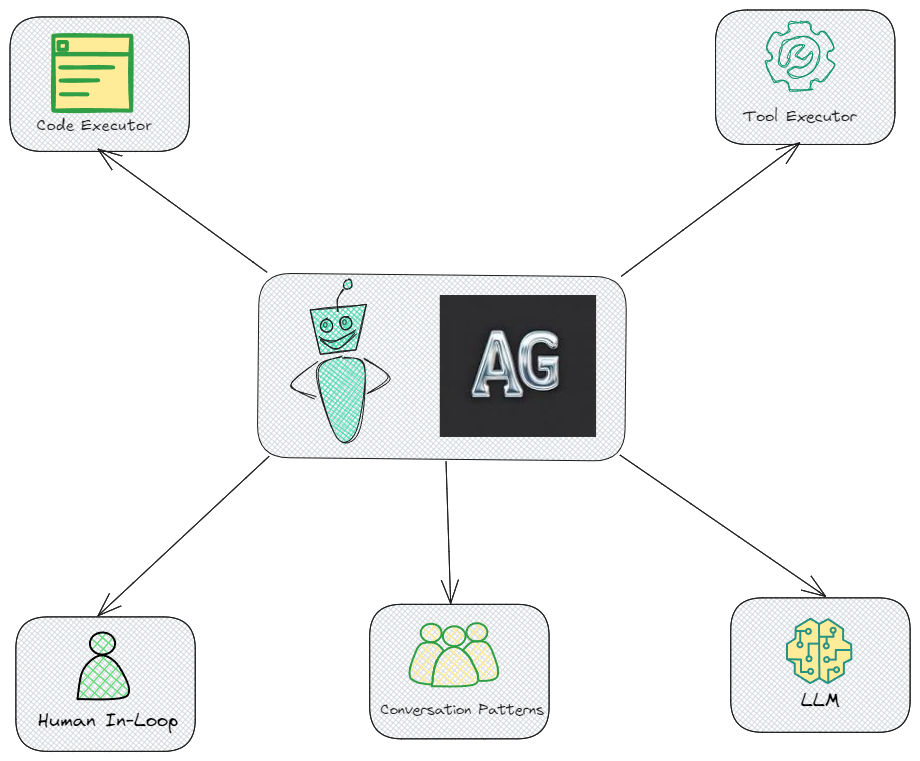

AutoGen是一个更专注于使用大型语言模型自动化代码生成过程和工作流管理的框架。它的主要目标是通过使用自然语言输入生成功能代码和自动化重复任务,加快开发过程。AutoGen非常适合快速原型设计,允许用户在不需要广泛的编程知识的情况下创建应用程序和工作流。

# AutoGen的组件

以下插图展示了AutoGen的所有关键组件,展示了它们如何相互交互:

- 代码执行器 - 此组件允许AutoGen自动运行代码。这是确保代理根据设定的目标执行代码的核心功能。

- 工具执行器 - 这个组件对于AutoGen也是必不可少的,它允许系统与各种外部工具或API进行交互。

- 人机协同 - 在需要人工干预进行决策或验证的情况下,这一点非常重要,确保人员可以在需要时指导或控制代理。

- 对话模式 - 这表明AutoGen采用预定义的对话结构来有效管理代理之间的交互。这是确保代理之间进行连贯和目标导向对话的重要元素。

- LLM(大型语言模型) - LLM是AutoGen架构的重要组成部分,提供了驱动代理理解和决策的底层语言能力。

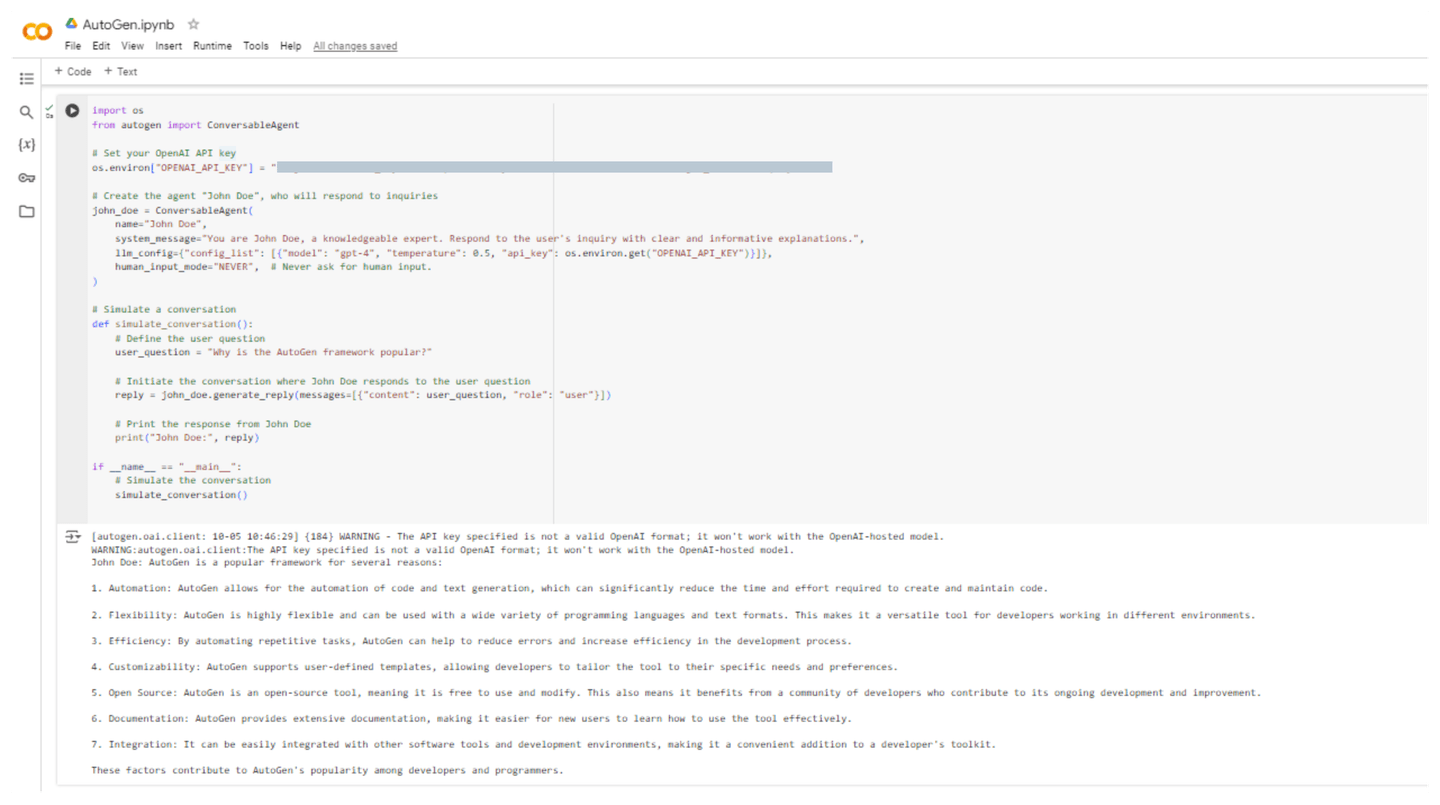

# 代码示例:创建AutoGen代理

现在让我们在AutoGen中创建相同的John Doe代理,他将解释**“为什么AutoGen框架受欢迎?”**代码如下所示:

import os

from autogen import ConversableAgent

# 设置您的OpenAI API密钥

os.environ["OPENAI_API_KEY"] = "[OPENAI API KEY]"

# 创建名为“John Doe”的代理,该代理将回答问题

john_doe = ConversableAgent(

name="John Doe",

system_message="You are John Doe, a knowledgeable expert. Respond to the user's inquiry with clear and informative explanations.",

llm_config={"config_list": [{"model": "gpt-4", "temperature": 0.5, "api_key": os.environ.get("OPENAI_API_KEY")}]},

human_input_mode="NEVER", # 从不要求人工输入。

)

# 模拟对话

def simulate_conversation():

# 定义用户问题

user_question = "Why is the AutoGen framework popular?"

# 启动John Doe回答用户问题的对话

reply = john_doe.generate_reply(messages=[{"content": user_question, "role": "user"}])

# 打印John Doe的回答

print("John Doe:", reply)

if __name__ == "__main__":

# 模拟对话

simulate_conversation()

执行此代码后,John Doe给出了以下解释的答案:

John Doe: AutoGen是一个受欢迎的框架,原因如下:

1. 自动化:AutoGen允许自动化代码和文本生成,可以显著减少创建和维护代码所需的时间和工作量。

2. 灵活性:AutoGen非常灵活,可以与各种编程语言和文本格式一起使用。这使其成为在不同环境中工作的开发人员的多功能工具。

3. 效率:通过自动化重复任务,AutoGen可以帮助减少错误并提高开发过程的效率。

4. 可定制性:AutoGen支持用户定义的模板,允许开发人员根据其特定需求和偏好定制工具。

5. 开源:AutoGen是一个开源工具,这意味着可以免费使用和修改。这也意味着它受益于一个为其持续发展和改进做出贡献的开发者社区。

6. 文档:AutoGen提供了广泛的文档,使新用户更容易学习如何有效使用该工具。

7. 集成:它可以轻松集成到其他软件工具和开发环境中,成为开发人员工具包中方便的补充。

这些因素使AutoGen在开发人员和程序员中受到欢迎。

以下屏幕截图展示了在Colab环境中执行此代码的情况:

# LangChain vs. AutoGen:比较概述

下表列出了LangChain和AutoGen之间的关键区别和相似之处。该表将帮助您了解每个框架的独特功能、优势和预期用例。

| 特征/方面 | LangChain | AutoGen |

|---|---|---|

| 目的 | 用于开发使用语言模型的应用程序,重点是链接操作和数据流。 | 用于使用多个可以通信和协作的代理实现复杂工作流的框架。 |

| 代理模型 | 支持构建自定义代理和工作流。 | 使用可以发送和接收消息的对话代理,简化多代理之间的交互。 |

| 社区 | 成熟的社区,有广泛的文档和示例。 | 不断发展的社区,有积极的开发和研究重点。 |

| 复杂工作流 | 可以构建复杂工作流,但主要通过链接操作来实现。 | 专为具有多个代理的复杂工作流设计,促进它们之间的交互。 |

| 易用性 | 对于熟悉LLMs的人来说很简单,但对于初学者来说可能有一定的学习曲线。 | 对于构建多代理系统来说非常用户友好,侧重于协作和通信。 |

| 用例 | 适用于数据处理、内容生成和对话代理等应用。 | 适用于需要多代理系统的应用,例如辩论、客户支持或协作问题解决。 |

| 集成 | 与各种LLMs、工具和外部服务集成良好。 | 专门设计用于代理和其组件的集成,包括人工输入。 |

| 人机协同 | 对人工参与的支持有限;更注重自动化。 | 支持人机协同场景,允许代理在必要时寻求人工输入。 |

| API使用 | 需要像OpenAI这样的LLMs的API密钥,但对代理之间的交互关注较少。 | 需要像LLMs这样的API密钥,专门设计用于代理之间的交互和工作流。 |

| 支持的模型 | 与各种模型配合使用,包括GPT-3、GPT-4等。 | 主要与OpenAI模型集成,但可以扩展以支持其他模型。 |

这张表提供了关于LangChain和AutoGen的优势和注意事项的快速概述,帮助您决定哪个工具最适合您的项目需求。

# 结论

LangChain和AutoGen是强大的框架,专为人工智能领域的各种目的而设计。LangChain专注于创建使用语言模型的有组织应用程序,使用模块化组件和工作流链接。这使其非常适合数据处理和生成内容等任务。另一方面,AutoGen在开发具有多个代理的交互式系统方面表现出色,这些代理可以共同工作和高效沟通,解决困难的任务,使人类更容易参与问题解决。

通过将MyScale (opens new window)与这两个框架结合使用,功能得到了极大的改进,因为它可以有效地存储和检索向量嵌入。这种集成使得在应用程序中可以快速检索相关信息,增强了上下文的适当性和响应的准确性。此外,MyScale的MSTG算法 (opens new window)改进了搜索和检索操作,以高效处理庞大的数据集。通过这些工具的协同作用,开发人员可以构建强大高效的基于AI的平台。